Từng làm việc cho một tổ chức lớn về trí tuệ nhân tạo tại Mỹ, vì sao ông lại quyết định về nước đầu quân cho VinBigdata?

Thời gian làm việc tại Mỹ, tuy được tham gia khá nhiều dự án lớn của Chính phủ, những kết quả mình làm ra thường chỉ là một vài bước trong một quy trình xử lý lớn. Thậm chí, nhiều lúc, do quy trình bảo mật rất nghiêm ngặt của các dự án, tôi còn không được biết các giải pháp mình đã phát triển đang được sử dụng như thế nào.

Năm 2017 tôi về nước là lúc Việt Nam đang trong giai đoạn phát triển và có nhiều bài toán về dữ liệu lớn và trí tuệ nhân tạo cần được giải quyết. Tôi nhận lời mời của GS Vũ Hà Văn để cùng thực hiện hóa mục tiêu phát triển những giải pháp công nghệ Việt, phục vụ cho đời sống người Việt. Tôi thấy việc trở về Việt Nam của mình có ý nghĩa hơn rất nhiều vì mình sẽ được làm những bài toán có sức ảnh hưởng lớn hơn.

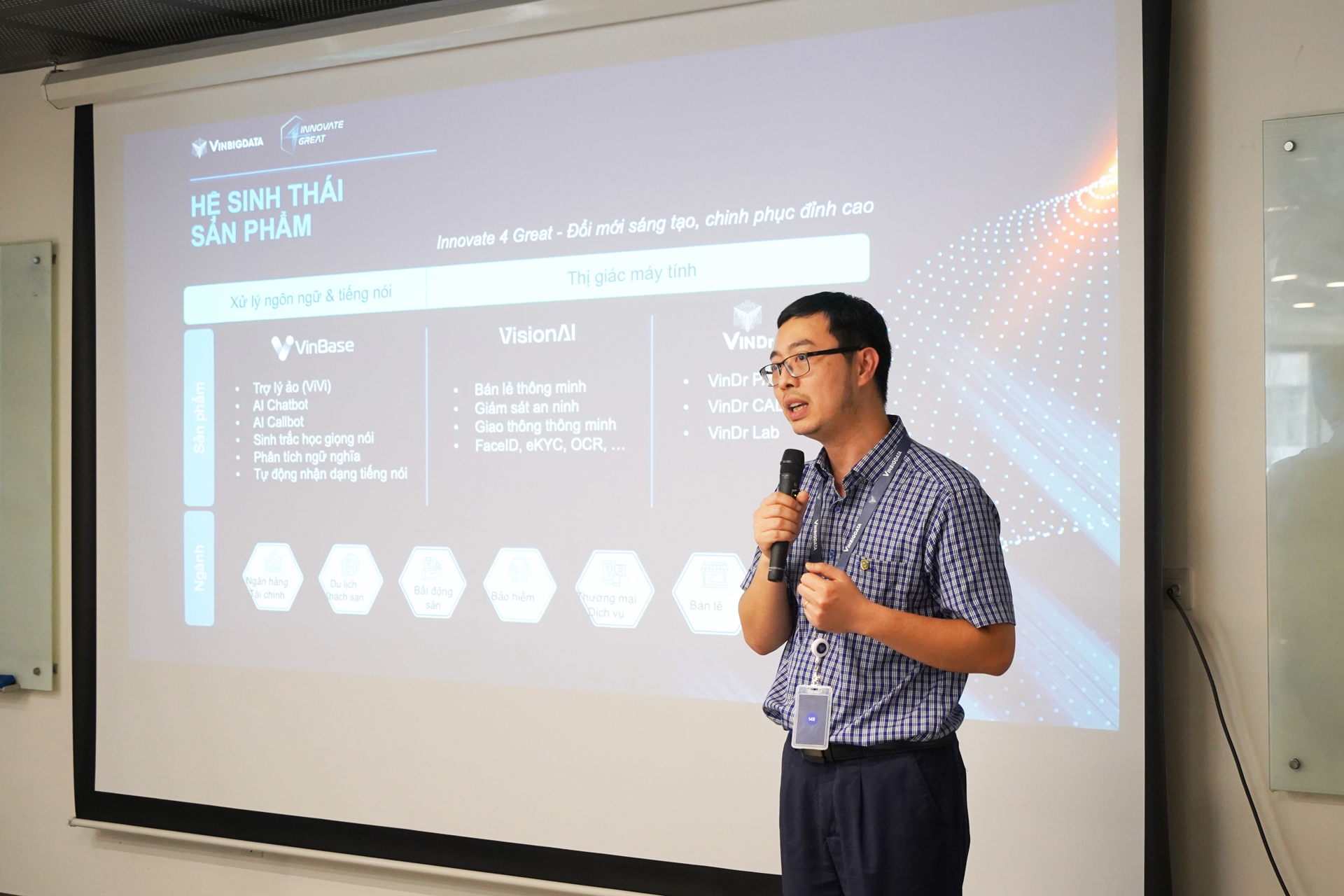

TS Đào Đức Minh trong một hội thảo

Trong chiến lược phát triển trí tuệ nhân tạo, dữ liệu lớn có vai trò và ảnh hưởng thế nào, thưa ông?

Dữ liệu đóng vai trò rất lớn và giá trị trong việc đào tạo trí tuệ nhân tạo. Để đào tạo một mô hình trí tuệ nhân tạo chất lượng cao thường bắt đầu từ việc huấn luyện một bộ cơ sở dữ liệu lớn. Do vậy, để có trí tuệ nhân tạo chất lượng, trước tiên ta cần phải có dữ liệu tốt.

Dữ liệu tốt cần phải đạt chuẩn về số lượng và quy mô, chất lượng, sự đa dạng và tính phổ quát. Quá trình thu thập và xử lý hàng nghìn giờ dữ liệu từ bước làm sạch dữ liệu thô để tạo ra dữ liệu chất lượng cao nhất đưa vào mô hình trí tuệ nhân tạo là rất tốn kém và phức tạp. Ngược lại, để phân tích dữ liệu lớn, chúng ta cần phải dùng tới trí tuệ nhân tạo để đảm bảo khả năng xử lí dữ liệu chính xác trên diện rộng, từ đó tạo ra những kết quả có tính quyết định hoặc tính dự đoán tốt hơn.

Ví dụ, trong quá trình phát triển sản phẩm trợ lý ảo cho người Việt (ViVi), chúng tôi đã phải thu thập, xử lý hàng chục nghìn giờ dữ liệu âm thanh chất lượng cao, từ hàng trăm nghìn giọng từ các vùng miền khác nhau, đa dạng lứa tuổi và giới tính, với nội dung trải dài hàng trăm lĩnh vực…

Hay gần đây nhất là việc ra mắt ViGPT – “ChatGPT phiên bản Việt đầu tiên dành cho người dùng cuối” được phát triển từ Mô hình ngôn ngữ lớn do VinBigdata làm chủ hoàn toàn. Mô hình này được huấn luyện dựa trên 600 GB dữ liệu tiếng Việt tinh chỉnh từ nhiều lĩnh vực khác nhau. Bằng những am hiểu về dữ liệu và ngôn ngữ tiếng Việt, chúng tôi đã tìm ra cách tiếp cận mới để rút ngắn thời gian ra mắt ViGPT chỉ trong vòng 9 tháng sau khi ChatGPT ra đời.

Đây là sự cộng hưởng giữa dữ liệu lớn và trí tuệ nhân tạo.

Quan điểm của ông về việc gắn liền nghiên cứu với giá trị thực tiễn để phục vụ cộng đồng?

– Tôi quan niệm rằng, nghiên cứu công nghệ chỉ thật sự thành công khi thực sự đi vào đời sống, giải quyết những vấn đề của xã hội và nâng cao đời sống người dân.

Để tạo ra những sản phẩm thương mại có tính thực tiễn và giải quyết được những vấn đề của doanh nghiệp và xã hội, cần luôn quan tâm và đặt ra câu hỏi: dữ liệu sẽ mang lại giá trị nào cho cuộc sống.

Đến thời điểm hiện tại, chúng tôi đã nghiên cứu ra các bộ sản phẩm và giải pháp đa dạng các ngành nghề lĩnh vực, điển hình như ViGPT, VinDr – cung cấp các giải pháp AI trong chẩn đoán hình ảnh y tế, VinBase – nền tảng trí tuệ nhân tạo tạo sinh, hay Vizone – bộ giải pháp phân tích hình ảnh thông minh.

Cùng các nhân sự chủ chốt của VinBigdata trong một sự kiện của Tập đoàn Vingroup

Cuộc cách mạng công nghiệp lần thứ 4 đã và đang diễn ra mạnh mẽ trên quy mô toàn cầu. Ông đánh giá Việt Nam có những lợi thế nào?

So với các cuộc cách mạng trước đây, tôi cho rằng Việt Nam hiện tại có rất nhiều lợi thế để bứt phá trong cuộc cách mạng công nghiệp 4.0 này, giúp nâng cao vị thế quốc gia trên bản đồ thế giới. Hai chìa khóa để thực hiện mục tiêu này chính là dữ liệu và con người.

Việt Nam hiện có gần 100 triệu dân, trong đó tỷ lệ dân số trẻ sử dụng điện thoại và máy tính cá nhân cao. Ngoài ra, chúng ta đang có những chuyên gia uy tín về trí tuệ nhân tạo cùng những nhân sự trẻ chất lượng về công nghệ thông tin và có nền tảng rất tốt về toán học.

Vậy còn những hạn chế?

Hạn chế đầu tiên có thể thấy đó là tuy có đặc thù dân số đông, chúng ta vẫn đang gặp khó khăn trong việc làm chủ dữ liệu, cụ thể ở đây là chuẩn hóa và đồng bộ các dữ liệu tại các cơ sở, đơn vị doanh nghiệp và hành chính.

Ngoài ra, chúng ta cũng đối mặt với những hạn chế khác như hạn chế về nguồn lực đầu tư, đặc biệt là đầu tư về cơ sở hạ tầng tính toán hiệu năng cao.

Theo ông, việc làm chủ dữ liệu Việt đóng vai trò quan trọng thế nào trong hành trình tạo ra và nắm giữ công nghệ, phục vụ cho đời sống người Việt?

Hiện có rất nhiều sản phẩm trí tuệ nhân tạo tiên phong hàng đầu đến từ thế giới, điển hình như các sản phẩm ứng dụng AI tạo sinh dựa trên nền tảng là mô hình ngôn ngữ lớn như ChatGPT của OpenAI hay Bard của Google. Tuy vậy, tiếng Việt không phải là nhóm ngôn ngữ trọng tâm phát triển của các sản phẩm này.

Do đó, chất lượng nội dung mang tính đặc thù của người Việt được trả về cho người dùng ít nhiều bị ảnh hưởng và có khả năng sai sót khá lớn, nguy hiểm hơn là sai lệch về mặt kiến thức cơ bản.

Là người Việt, chúng ta có lợi thế trong việc tiếp cận nguồn dữ liệu của riêng mình. Chỉ có chúng ta mới có khả năng thấu hiểu những đặc tính của dữ liệu Việt, nhu cầu và đặc điểm của người Việt. Do đó, làm chủ được dữ liệu Việt thực sự là chìa khóa để nắm giữ các công nghệ lõi, cũng chính là các công nghệ sẽ phục vụ người Việt.

Đào tạo nội bộ cho các thành viên thuộc VinBigdata

Làm sao để tiếp cận với nguồn dữ liệu đặc thù, nhất là khi phần lớn người Việt hiện nay sử dụng các trang mạng xã hội đến từ nước ngoài?

Thực tế là nguồn dữ liệu lớn nhất của con người hiện nay (không chỉ của người Việt) nằm trên internet và mạng xã hội. Tuy vậy, ta vẫn có thể tiếp cận và thu thập dữ liệu từ các nguồn khác nhau, dựa vào sự hiểu biết về đặc tính dữ liệu Việt, tùy thuộc vào đặc tính do từng dự án đặt ra.

Ví dụ, các mô hình GPT của OpenAI có tới hàng trăm, thậm chí hàng nghìn tỉ tham số, được đào tạo trên lượng dữ liệu khổng lồ và tiêu tốn tới hàng tỉ đô. So với họ, chúng tôi đã lựa chọn một hướng đi hoàn toàn khác biệt dựa trên những nghiên cứu, khả năng và nguồn lực mình có: đó là tạo ra mô hình ngôn ngữ Việt với kiến trúc chỉ một vài tỉ tham số, được đào tạo trên bộ 600 GB dữ liệu tiếng Việt do chúng tôi tự thu thập và tinh chỉnh, nhưng có khả năng tương đương về khả năng xử lý tiếng Việt. Kết quả cho thấy kiến trúc chúng tôi tự phát triển có thể tự tối ưu, rút ngắn thời gian huấn luyện mô hình ngôn ngữ, giảm chi phí nhưng vẫn đảm bảo chất lượng mô hình.

Đâu là những thách thức mà ông cùng đội ngũ đã gặp phải trong quá trình nghiên cứu và phát triển các sản phẩm trí tuệ nhân tạo?

Thách thức đầu tiên chắc hẳn là thời gian. Làn sóng công nghệ trí tuệ nhân tạo đến rất nhanh và đang trong thời kỳ bùng nổ. Trên thế giới, các công ty lớn hàng đầu về công nghệ đã nhanh chóng cho ra mắt những sản phẩm có sự hoàn thiện cao, liên tục được cập nhật, cải tiến. Nếu chúng ta chậm chân và không đưa ra sản phẩm kịp thời, chắc chắn sẽ tụt lại phía sau.

Mặt khác, nếu muốn tạo ra những sản phẩm có khả năng áp dụng và giải được những bài toán thực tiễn xã hội, chúng ta cũng phải cân nhắc tìm và phát triển được những điểm nổi bật, đặc sắc và độc nhất của sản phẩm.

Thuyết trình tại Ngày hội Trí tuệ nhân tạo Việt Nam (AI4VN 2023)

Thực tế cho thấy, nhiều cá nhân, tổ chức tại Việt Nam, thế giới đã bị thiệt hại rất nhiều trong những sự việc rò rỉ dữ liệu. Ông nhìn nhận vấn đề bảo mật dữ liệu thế nào?

Có thể nói, bất kỳ ứng dụng nào hiện nay cũng xuất phát từ dữ liệu. Khi làm việc với dữ liệu, một mặt phải đảm bảo mục tiêu ứng dụng dữ liệu làm ra những công nghệ tốt nhất cho cuộc sống, mặt khác phải đảm bảo an toàn bảo mật dữ liệu cho các cá nhân, tổ chức.

Yếu tố con người là mắt xích rất quan trọng trong quy trình đảm bảo an toàn dữ liệu. Họ bao gồm người phát triển, đơn vị sử dụng sản phẩm và người dùng. Đối với những người phát triển, ý thức về việc bảo mật dữ liệu phải có từ những bước đầu trong việc thu thập và xử lý dữ liệu.

Thường thì khi chưa có vấn đề gì xảy ra, chúng ta chưa ý thức được tầm quan trọng của bảo mật dữ liệu. Nhưng nếu việc rò rỉ dữ liệu xảy ra, thiệt hại có thể sẽ rất lớn. Rò rỉ dữ liệu có thể xảy ra vì sự cố kỹ thuật hay vì những chủ ý tấn công ăn cắp dữ liệu. Khi bị rò rỉ dữ liệu, cá nhân hay tổ chức có thể bị kẻ xấu sử dụng thông tin với những mục đích phi pháp, còn doanh nghiệp có thể sẽ bị tổn hại về tài chính để khắc phục các sự cố liên quan, thậm chí là tổn hại về thương hiệu.

TS Đào Đức Minh và team VinBigdata trong một sự kiện

Sau khát vọng làm chủ công nghệ phục vụ người Việt hẳn sẽ là những bước đi tiến ra thế giới?

Bất cứ tổ chức, doanh nghiệp nào khi muốn đưa những sản phẩm của mình ra thị trường quốc tế đều cần tuân thủ những tiêu chuẩn quốc tế. VinBigdata có thế mạnh về giải pháp và công nghệ, nên việc đặt tầm nhìn tiến ra chinh phục thế giới là điều đương nhiên.

Tất nhiên, để triển khai cho nhiều sản phẩm, ứng dụng khác nhau thì cần sự đồng hành của các đơn vị quốc tế có kinh nghiệm lâu năm và có sự hiểu biết về người sử dụng trên thế giới.

Xin cảm ơn ông!

Nguồn: https://thanhnien.vn/ts-dao-duc-minh-lam-chu-du-lieu-viet-la-buoc-dau-phat-trien-va-nam-giu-cong-nghe-viet-18524052710263732.htm