엔비디아는 3월 18일 개발자 행사에서 인공지능(AI) 시장에서의 입지를 강화하기 위해 일련의 신제품을 발표했습니다. ChatGPT가 2022년 말 글로벌 AI 경쟁에 뛰어든 이후 칩 제조업체의 주가는 54배나 급등했고 매출은 3배 이상 증가했습니다. Nvidia의 고성능 서버 GPU는 대규모 언어 모델을 훈련하고 배포하는 데 필수적입니다. Microsoft와 Meta 같은 회사는 칩을 구입하는 데 수십억 달러를 썼습니다.

엔비디아는 새로운 세대의 AI 칩을 블랙웰이라고 명명했습니다. 최초의 블랙웰 칩인 GB200은 올해 말에 출시될 예정입니다. 엔비디아는 새로운 주문을 촉진하기 위해 고객에게 더욱 강력한 칩을 제공하고 있습니다. 현재 고객들은 여전히 H100 Hopper 칩을 손에 넣기 위해 노력하고 있습니다.

엔비디아 CEO 젠슨 황은 이 행사에서 "호퍼는 훌륭하지만 더 큰 GPU가 필요합니다." 라고 말했습니다.

엔비디아는 블랙웰 칩과 함께 AI 배포를 보다 쉽게 만드는 NIM 소프트웨어도 출시했습니다. 엔비디아 관계자에 따르면, 이 회사는 칩 공급업체라기보다는 애플과 마이크로소프트와 같은 플랫폼 공급업체로 점차 변모하고 있다.

황 씨는 "블랙웰은 칩이 아니라 플랫폼의 이름입니다." 라고 말했습니다. 엔비디아 부사장 마누비르 다스는 프로그래머가 구형이든 신형이든 모든 엔비디아 GPU에서 프로그램을 실행하여 더 많은 사람들에게 다가갈 수 있도록 돕는 NIM 소프트웨어를 약속했습니다.

블랙웰, 호퍼의 "후계자"

엔비디아는 2년마다 GPU 아키텍처를 업데이트하여 새로운 성능 향상을 실현합니다. 작년에 출시된 많은 AI 모델은 2022년에 등장한 Hopper 아키텍처를 기반으로 훈련되었습니다.

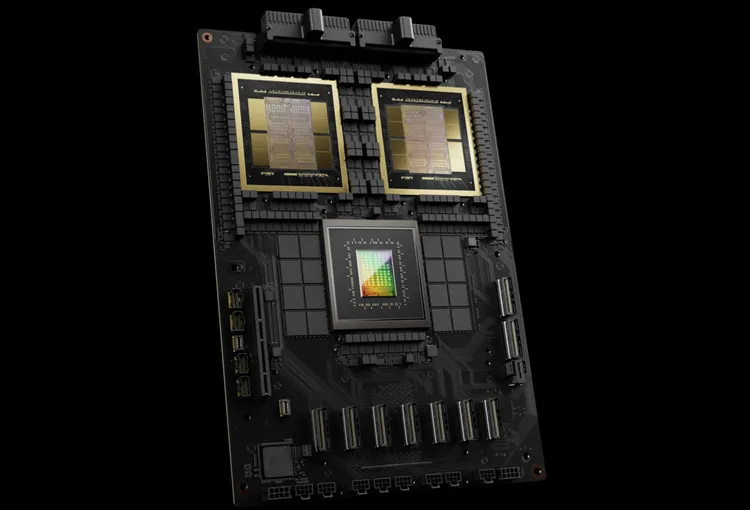

엔비디아는 GB200과 같은 블랙웰 기반 칩이 AI 기업에 상당한 AI 성능 업그레이드를 제공한다고 밝혔습니다. H100의 4페타플롭스에 비해 20페타플롭스에 달합니다. 이러한 처리 능력을 통해 AI 기업은 더 크고 복잡한 모델을 훈련할 수 있습니다.

블랙웰 GPU는 크기가 크고, 별도로 제조된 두 개의 다이를 하나의 칩으로 결합했습니다. 또한, AI 모델을 훈련하도록 설계된 72개의 Blackwell GPU와 기타 Nvidia 부품을 결합한 GB200 NVLink 2라는 완전한 서버로도 제공됩니다.

Amazon, Google, Microsoft, Oracle은 클라우드 서비스를 통해 GB200에 대한 액세스를 판매할 예정입니다. GB200은 두 개의 B200 Blackwell GPU와 Grace CPU를 결합한 제품입니다. 엔비디아는 Amazon Web Services(AWS)가 20,000개의 GB200 칩을 사용하여 서버 클러스터를 구축할 것이라고 밝혔습니다.

이 시스템은 현재 가장 큰 모델인 GPT-4(매개변수 1.7조 개)보다 훨씬 큰 27조 개의 매개변수 모델을 배포할 수 있습니다. 많은 AI 연구자들은 더 많은 매개변수와 데이터를 갖춘 대규모 모델이 새로운 역량을 발휘할 수 있다고 믿습니다.

엔비디아는 새로운 GB200이나 GB200이 포함된 시스템의 가격을 발표하지 않았습니다. 분석가들의 추정에 따르면, 엔비디아의 호퍼 기반 H100의 가격은 대당 25,000달러에서 40,000달러 사이이고, 전체 시스템 비용은 최대 200,000달러에 이릅니다.

(CNBC에 따르면)

[광고_2]

원천

![[사진] 5월, 호치민 주석 고향에 연꽃이 활짝 피어](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/15/aed19c8fa5ef410ea0099d9ecf34d2ad)

![[사진] 루옹 꾸엉 대통령, 호치민 주석의 착한 아이들을 기리는 전국 행사 참석](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/15/9defa1e6e3e743f59a79f667b0b6b3db)

![[사진] 팜 민 찐 총리, 세계은행 베트남·라오스·캄보디아 지역사무소장 접견](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/15/2c7898852fa74a67a7d39e601e287d48)

![[사진] 6월 개통 예정인 안푸 지하차도 클로즈업](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/15/5adb08323ea7482fb64fa1bf55fed112)

댓글 (0)