គំរូនេះមានសមត្ថភាពវែកញែក ដោះស្រាយបញ្ហាគណិតវិទ្យាដ៏ស្មុគស្មាញ និងឆ្លើយសំណួរស្រាវជ្រាវវិទ្យាសាស្ត្រ ដែលត្រូវបានចាត់ទុកថាជាជំហានទៅមុខដ៏សំខាន់ក្នុងកិច្ចខិតខំប្រឹងប្រែងដើម្បីអភិវឌ្ឍបញ្ញាទូទៅសិប្បនិម្មិត (AGI) ដែលជាម៉ាស៊ីនដែលមានសមត្ថភាពយល់ដឹងដូចមនុស្ស។

OpenAI បាននិយាយថា វាមាន "ការប្រុងប្រយ័ត្ន" ជាពិសេសអំពីរបៀបដែលវានាំយកគំរូ o1 ទៅកាន់សាធារណៈជន ដោយសារសមត្ថភាពកម្រិតខ្ពស់របស់វា។ រូបថត៖ រូបភាព Getty

យោងតាមកាសែត Financial Times OpenAI បានវាយតម្លៃហានិភ័យនៃម៉ូដែលថ្មីទាំងនេះថាជា "មធ្យម" សម្រាប់បញ្ហាទាក់ទងនឹងអាវុធគីមី ជីវសាស្រ្ត វិទ្យុសកម្ម និងនុយក្លេអ៊ែរ (CBRN) ដែលជាចំនួនខ្ពស់បំផុតដែលក្រុមហ៊ុនមិនធ្លាប់បានវាយតម្លៃ។ នេះមានន័យថាបច្ចេកវិទ្យាបាន "ធ្វើឱ្យប្រសើរឡើងយ៉ាងខ្លាំង" សមត្ថភាពរបស់អ្នកជំនាញក្នុងការបង្កើតអាវុធជីវសាស្រ្ត។

យោងតាមអ្នកជំនាញ កម្មវិធី AI ដែលមានសមត្ថភាពវែកញែកលម្អិត ជាពិសេសនៅក្នុងដៃរបស់តួអង្គអាក្រក់ អាចបង្កើនហានិភ័យនៃការរំលោភបំពាន។

សាស្ត្រាចារ្យ Yoshua Bengio ដែលជាអ្នកវិទ្យាសាស្ត្រ AI ឈានមុខគេលើពិភពលោកមកពីសាកលវិទ្យាល័យ Montreal បានសង្កត់ធ្ងន់ថាកម្រិតហានិភ័យមធ្យមនេះបង្កើនភាពបន្ទាន់ក្នុងការអនុម័តបទប្បញ្ញត្តិ AI ដូចជាវិក័យប័ត្រ SB 1047 ដែលកំពុងត្រូវបានពិភាក្សានៅរដ្ឋកាលីហ្វ័រញ៉ា។ វិក័យប័ត្រនេះនឹងតម្រូវឱ្យអ្នកផលិត AI ចាត់វិធានការដើម្បីកាត់បន្ថយហានិភ័យនៃគំរូរបស់ពួកគេដែលត្រូវបានប្រើប្រាស់ខុសដើម្បីបង្កើតអាវុធជីវសាស្ត្រ។

យោងតាមគេហទំព័រ The Verge សុវត្ថិភាព និងសុវត្ថិភាពនៃម៉ូដែល AI បានក្លាយជាកង្វល់ដ៏ធំមួយ ខណៈដែលក្រុមហ៊ុនបច្ចេកវិទ្យាដូចជា Google, Meta និង Anthropic កំពុងប្រជែងគ្នាដើម្បីបង្កើត និងកែលម្អប្រព័ន្ធ AI កម្រិតខ្ពស់។

ប្រព័ន្ធទាំងនេះមានសក្តានុពលក្នុងការផ្តល់នូវអត្ថប្រយោជន៍ដ៏អស្ចារ្យក្នុងការជួយមនុស្សឱ្យបំពេញកិច្ចការ និងការផ្តល់ជំនួយក្នុងវិស័យផ្សេងៗ ប៉ុន្តែក៏បង្កបញ្ហាប្រឈមសុវត្ថិភាព និងទំនួលខុសត្រូវសង្គមផងដែរ។

Cao Phong (យោងតាម FT, Reuters, The Verge)

ប្រភព៖ https://www.congluan.vn/openai-thua-nhan-mo-hinh-ai-moi-co-the-duoc-su-dung-de-tao-ra-vu-khi-biological-hoc-post312337.html

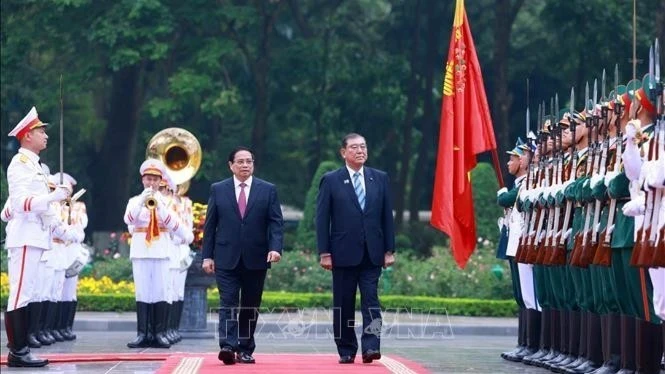

![[រូបថត] ប្រធានរដ្ឋសភាលោក Tran Thanh Man ជួបជាមួយនាយករដ្ឋមន្ត្រីជប៉ុន Ishiba Shigeru](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/2517da8f7b414614b8ed22cd6c49c3f6)

![[រូបថត] យុវជនជួរវែងនៅមុខកាសែត Nhan Dan រំលឹកអនុស្សាវរីយ៍នៃថ្ងៃដែលប្រទេសត្រូវបានបង្រួបបង្រួម](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/4709cea2becb4f13aaa0b2abb476bcea)

![[រូបថត] ប្រជាជនតម្រង់ជួរក្នុងភ្លៀង ដោយអន្ទះសារទទួលអាហារបំប៉នពិសេសរបស់កាសែត Nhan Dan](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/ce2015509f6c468d9d38a86096987f23)

![[រូបថត] ពិធីចុះហត្ថលេខាលើកិច្ចសហប្រតិបត្តិការ និងផ្លាស់ប្តូរឯកសាររវាងវៀតណាម និងជប៉ុន](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/e069929395524fa081768b99bac43467)

![[រូបថត] ការបន្ថែមពិសេសរបស់កាសែត Nhan Dan ផ្សព្វផ្សាយដល់អ្នកអានទូទាំងប្រទេស](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/0d87e85f00bc48c1b2172e568c679017)

![[រូបថត] អ្នកអាននៅដុងណៃ រំភើបនឹងការបន្ថែមពិសេសរបស់កាសែត ញ៉ាន ដាន](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/82cdcb4471c7488aae5dbc55eb5e9224)

Kommentar (0)