3月18日の開発者イベントで、Nvidiaは人工知能(AI)市場での地位を強化するための一連の新製品を発表した。 ChatGPTが2022年後半に世界的なAI競争を開始して以来、このチップメーカーの株価は54倍に急騰し、収益は3倍以上に増加した。NvidiaのハイエンドサーバーGPUは、大規模な言語モデルのトレーニングと展開に不可欠である。 MicrosoftやMetaなどの企業はチップの購入に数十億ドルを費やしてきた。

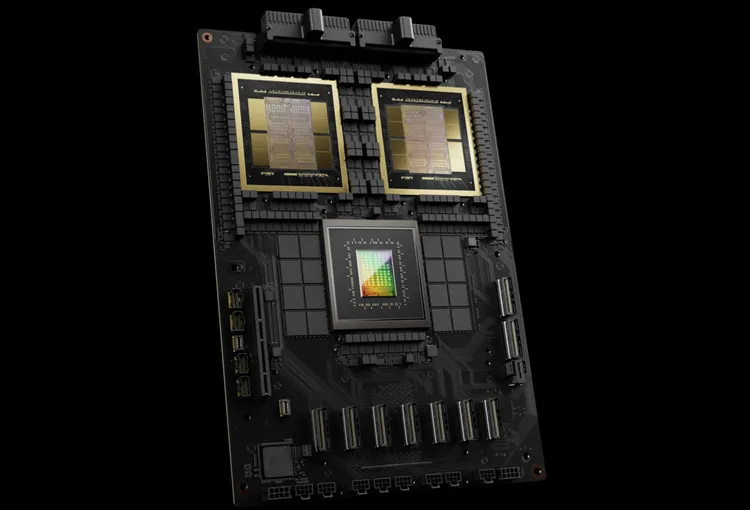

Nvidia は新世代の AI チップを Blackwell と名付けました。最初のブラックウェル チップ「GB200」は今年後半に発売される予定です。エヌビディアは新規受注を促進するため、より強力なチップを顧客に提供している。現在、顧客は H100 Hopper チップの入手に奮闘中です。

「Hopper は素晴らしいが、もっと大きな GPU が必要だ」とNvidia の CEO である Jensen Huang 氏はイベントで語った。

Nvidia は Blackwell チップとともに、AI の導入を容易にする NIM ソフトウェアも導入しました。 Nvidiaの関係者によると、同社はチップサプライヤーというより、AppleやMicrosoftのようなプラットフォームプロバイダーになりつつあるという。

「ブラックウェルはチップではなく、プラットフォームの名前です」と黄氏は語った。 Nvidia 副社長の Manuvir Das 氏は、NIM ソフトウェアにより、プログラマーが新旧のあらゆる Nvidia GPU でプログラムを実行できるようになり、より多くの人々にリーチできるようになると約束しています。

ホッパーの後継者、ブラックウェル

Nvidia は 2 年ごとに GPU アーキテクチャを更新し、新たなパフォーマンスの向上を実現します。昨年リリースされた多くの AI モデルは、2022 年に登場した Hopper アーキテクチャでトレーニングされました。

Nvidia によると、GB200 のような Blackwell ベースのチップは、AI ビジネスにとって AI パフォーマンスの大幅な向上をもたらし、H100 の 4 ペタフロップスに対して 20 ペタフロップスを実現します。この処理能力により、AI 企業はより大規模で複雑なモデルをトレーニングできるようになります。

Blackwell GPU は大型で、別々に製造された 2 つのダイを 1 つのチップに組み合わせています。また、AI モデルのトレーニング用に設計された 72 個の Blackwell GPU とその他の Nvidia パーツを組み合わせた、GB200 NVLink 2 と呼ばれる完全なサーバーとしても利用できます。

Amazon、Google、Microsoft、Oracleはクラウドサービスを通じてGB200へのアクセスを販売する。 GB200 は、2 つの B200 Blackwell GPU と Grace CPU を組み合わせたものです。エヌビディアは、アマゾン ウェブ サービス (AWS) が 20,000 個の GB200 チップを搭載したサーバー クラスターを構築する予定であると述べた。

このシステムは、GPT-4 (1.7兆パラメータ) などの現在の最大モデルよりもはるかに大きい、27兆パラメータのモデルを展開できます。多くの AI 研究者は、より多くのパラメータとデータを持つ大規模なモデルによって新たな機能が実現できると考えています。

Nvidia は新しい GB200 や GB200 を搭載したシステムの価格をまだ発表していません。アナリストの推計によると、Nvidia の Hopper ベースの H100 は 1 台あたり 25,000 ~ 40,000 ドル、システム全体のコストは最大 200,000 ドルです。

(CNBCによると)

[広告2]

ソース

コメント (0)