Tech.coの情報筋によると、CEOのサム・アルトマン氏が解雇され、その後OpenAIに復帰したことをめぐる論争が続く中、噂の一つは同社の研究者らが取締役会に送った手紙に関するもので、開発中のAI超知能モデルが人類に潜在的に脅威を与える可能性があるという懸念を表明していたという。

(図)

プロジェクトQ*

社内でプロジェクトQ*(Qスターと発音)と呼ばれているこのモデルは、OpenAIの汎用人工知能(AGI)の追求における大きな進歩を表すと言われている。AGIは、累積的な学習が可能で、ほとんどのタスクで人間を上回る能力を持つ、高度に自律的な超知能の一分野である。

事情に詳しい関係者によると、Q*はAIの推論能力を劇的に向上させ、OpenAIをAGI開発における大きな躍進に近づけることで、人工知能に大きな飛躍をもたらす可能性があるという。

以前に学習した情報に基づいて応答を生成する能力に重点を置く現在の AI モデルとは異なり、AGI は意思決定に「理由」を適用できる自律システムであり、人間レベルの問題解決能力を備えています。

AGI はまだ完全には実現されていないものの、多くの専門家は、このテクノロジーには、人間に能力を向上させる能力を与えるもう 1 つの特性である累積的に学習する能力も備わっていると考えています。

いくつかの情報源によれば、OpenAI のプロジェクトである Q* は、問題を解決する際に上記の特性を発揮することができたとのことです。それだけでなく、モデルの膨大な計算能力のおかげで、Q* は小学生を上回る成績を収め、現在の AI テクノロジーの能力をはるかに超える推論能力と認知能力を発揮しました。

Q* がどれくらいの期間開発されてきたのか、またその用途はどのようなものなのかは不明だが、人事スキャンダルが発覚する前に、OpenAI は従業員と役員にこのプロジェクトについて知らせていた。

倫理的な懸念

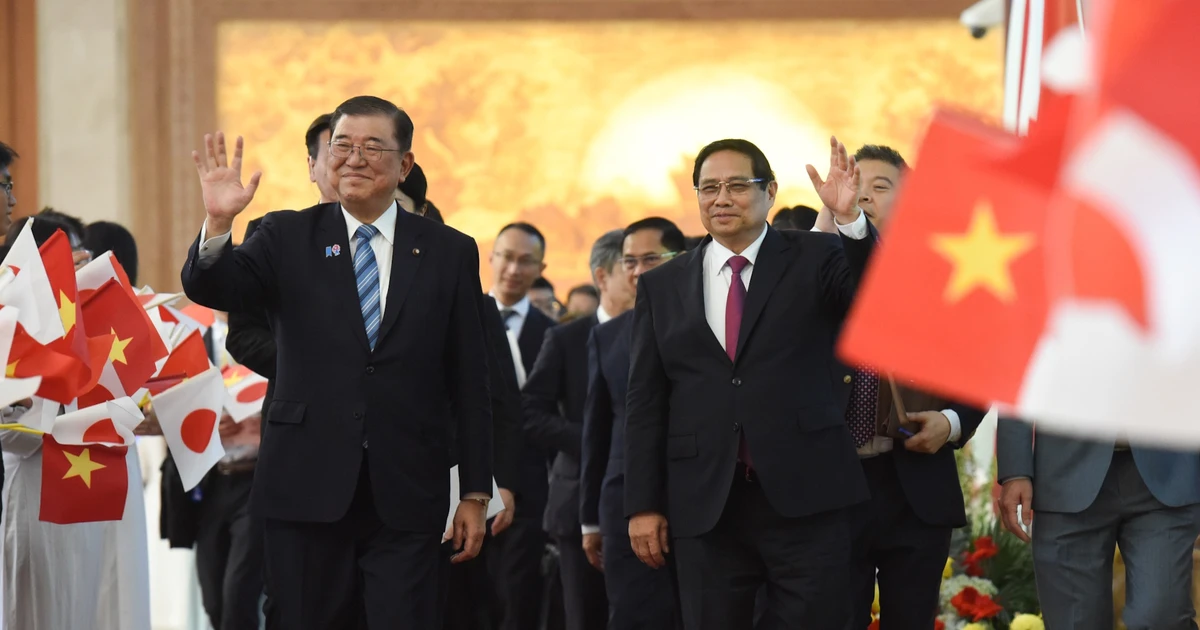

OpenAIのCEOサム・アルトマン氏はAGI技術がイノベーションを推進すると確信しているが、一部の研究者はプロジェクトの潜在的な危険性をいち早く指摘している。

研究者らは委員会に宛てた書簡の中で、この強力なアルゴリズムが人類に及ぼす潜在的な危険性について警告した。書簡で述べられたAI倫理に関する具体的な懸念は明らかにされていないが、その警告は取締役会がアルトマン氏を解雇する決定を正当化するのに十分だった。

一方、アルトマン氏を解雇した当初の理由は、CEOの「コミュニケーションが不十分だった」ためだった。その後間もなく、彼はマイクロソフトで新しい職を見つけました。この動きを受けて、OpenAIの従業員770人のうち700人が、CEOが復職しない場合は同じことをすると脅した。

同社が倒産の危機に瀕していたため、OpenAIの取締役会はアルトマン氏を最高経営責任者に復帰させざるを得なかった。これにより同社の経営陣も大幅に刷新され、経営陣内の深い分裂が浮き彫りになった。

アルトマン氏が大統領に復帰し、プロジェクトQ*が再び承認される可能性が高くなった今、新たな疑問が生じている。

プロジェクトQ*はどの程度現実的でしょうか?

OpenAI での激動の日々により AGI の概念が脚光を浴びているが、アルトマン氏がこの技術について言及したのはこれが初めてではない。

9月、シリコンバレーの起業家はAGIを「同僚として雇うかもしれない平均的な人間」と比較したことで苦境に立たされた。同氏はさらに、このAIは優れた医師やプログラマーになる方法を学ぶことを含め、「遠く離れた同僚とできることは何でもできる」という昨年のコメントを認めた。

AGIを「平均的な人間」の知能と比較すること自体は目新しいことではないが、AIが雇用の安定に及ぼす影響についての懸念が高まる中、アルトマン氏がこの表現を使ったことは、AI倫理学者でケンブリッジ大学教授のヘンリー・シェブリン氏から「忌まわしい」とみなされた。

AGI における潜在的なブレークスルーは、他の研究者たちに警鐘を鳴らしている。その技術は、人間がその影響を完全に理解できるよりも速いペースで開発されているのだ。

OpenAI は、AGI の肯定的な結果により、危険な「地雷原」を試してみる価値があると考えています。しかし、同社がこの方向へ進み続けるにつれ、アルトマン氏がユーザーや社会の利益よりも商業的成功を優先しているのではないかと懸念する人も多い。

フォン・アイン(出典: Tech.co、ガーディアン)

[広告2]

ソース

![[写真] ニャンダン新聞社前には、国が再統一された日の思い出を振り返る若者たちの長い列が並んでいる。](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/4709cea2becb4f13aaa0b2abb476bcea)

![[写真] ドンナイ省の読者はニャンダン新聞の特別付録に興奮している](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/82cdcb4471c7488aae5dbc55eb5e9224)

![[写真] 雨の中、ニャンダン新聞の特別付録を熱心に受け取る人々](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/28/ce2015509f6c468d9d38a86096987f23)

コメント (0)