MetaのCEO、マーク・ザッカーバーグ氏は1月18日、同社のAIに関する「将来のロードマップ」には「大規模なコンピューティングインフラ」の構築が必要だとInstagram Reelsに投稿した。 2024 年末までに、このインフラストラクチャは 350,000 個の Nvidia H100 チップによって提供される予定です。

|

| マーク・ザッカーバーグ氏は、AIが2024年のMetaの最優先投資分野であると述べています。 |

ザッカーバーグ氏は購入したグラフィック処理装置(GPU)の数を明らかにしていないが、Nvidia H100は2022年後半に発売される予定で、供給量は極めて限られている。レイモンド・ジェームズのアナリストは、NVIDIA が H100 チップを 25,000 ドルから 30,000 ドルで販売すると見積もっている。 eBayでは、このチップの価格は4万ドルを超えることもある。 Metaが低価格で買収できれば、そのコストは90億ドル近くになる。

さらにMeta CEOは、他のGPUも含めると、インフラストラクチャの計算能力は60万台のH100に相当するとも明らかにしました。 2023年12月、Meta、OpenAI、Microsoftは、AMDの新しいInstinct MI300X AIチップを使用すると発表した。

Metaがこれほど多くの「高耐久性」コンピュータチップを必要とする理由は、同社がザッカーバーグ氏が「長期的ビジョン」と呼ぶ汎用人工知能(AGI)を追求しているためだ。 OpenAIとGoogleのDeepMindも、人間の知能に匹敵すると期待される未来のAIであるAGIの開発に取り組んでいる。

Metaの主任科学者であるヤン・ルカン氏も、先月米国サンフランシスコで開催されたイベントでGPUの重要性を強調しました。 AGI が欲しいなら、GPU をさらに購入する必要があると彼は考えています。 「AI競争があり、彼(Nvidia CEO ジェンスン フアン)が武器を提供しているのです。」

メタは2023年第3四半期の収益報告で、2024年の総支出はコンピューティング能力の拡大も含め、940億ドルから990億ドルの範囲になると述べた。同グループのトップはアナリストとの会合で、 「投資の優先順位で言えば、AIは技術面でもコンピューティングリソース面でも2024年の最大の投資分野だ」とも断言した。

マーク・ザッカーバーグ氏は、Metaが開発中の「汎用AI」モデルを「責任を持ってオープンソース化」する計画だと述べた。これは同社が大規模言語製品ライン「Llama」で採用しているアプローチだ。

Metaは現在、Llama 3をトレーニングするとともに、Fundamental AI Research (FAIR)チームとGenAI研究チームがより緊密に連携できるようサポートしています。

[広告2]

ソース

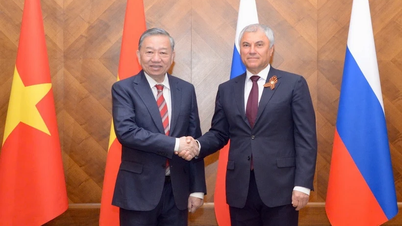

![[写真] ト・ラム書記長がロシアのプーチン大統領と短時間会談](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/10/bfaa3ffbc920467893367c80b68984c6)

コメント (0)