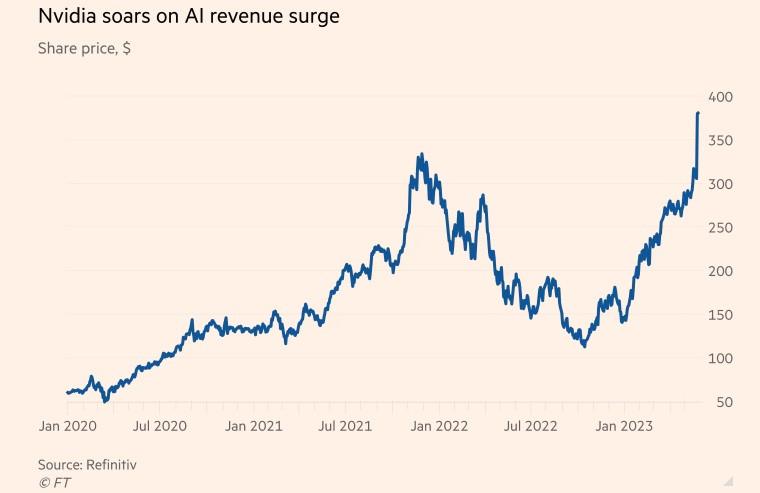

Nvidia từng được biết đến là nhà sản xuất chip dùng trong lĩnh vực trò chơi điện tử, song đã chuyển trọng tâm sang thị trường trung tâm dữ liệu trong vài năm trở lại đây.

Công ty chip Mỹ nhanh chóng “ăn nên, làm ra” trong thời kỳ đại dịch khi nhu cầu chơi game và ứng dụng đám mây tăng cao, cũng như “cơn sốt” đào coin lan khắp thế giới. Đến hết năm tài chính kết thúc vào ngày 29/1, mảng kinh doanh chip trung tâm dữ liệu chiếm hơn 50% doanh thu công ty.

Trong khi đó, chatbot đình đám ChatGPT đưa trí tuệ nhân tạo (AI) tạo sinh lên một tầm cao mới vào năm nay. Công nghệ này sử dụng lượng lớn dữ liệu sẵn có để tạo ra những nội dung mới trên nhiều chủ đề, từ làm thơ cho đến lập trình máy tính.

Microsoft và Alphabet, hai gã khổng lồ công nghệ, cũng là những tay chơi lớn trong không gian AI, tin rằng công nghệ tạo sinh có thể thay đổi cách thức làm việc của con người. Cả hai đã phát động cuộc đua tích hợp AI vào công cụ tìm kiếm cũng như các phần mềm văn phòng với tham vọng thống lĩnh ngành công nghiệp này.

Goldman Sachs ước tính đầu tư của Mỹ vào AI có thể xấp xỉ 1% sản lượng kinh tế của nước này vào năm 2030.

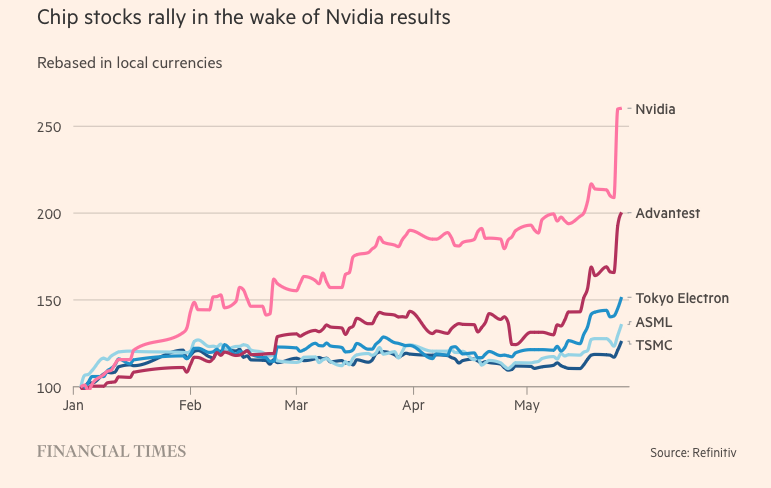

Các siêu máy tính dùng để xử lý dữ liệu và chạy AI tạo sinh hoạt động dựa trên các đơn vị xử lý hình ảnh (GPU). GPU được thiết kế để xử lý những phép toán đặc thù liên quan đến điện toán AI, có hiệu quả cao hơn hẳn những đơn vị xử lý trung tâm của các hãng chip khác như Intel. Chẳng hạn, ChatGPT của OpenAI được cung cấp sức mạnh từ hàng nghìn GPU Nvidia.

Trong khi đó, Nvidia đang chiếm khoảng 80% thị phần GPU. Đối thủ cạnh tranh chính của Nvidia bao gồm Advanced Micro Devices và chip AI nội bộ của các doanh nghiệp công nghệ như Amazon, Google và Meta Platforms.

Bí kíp thăng hoa

Bước nhảy vọt của công ty này nhờ vào H100, con chip dựa trên nền tảng kiến trúc mới của Nvidia có tên “Hopper” - được đặt theo tên của “cánh chim đầu đàn” lĩnh vực lập trình người Mỹ Grace Hopper. Sự bùng nổ của AI tạo sinh biến H100 trở thành mặt hàng "nóng" nhất tại thung lũng Silicon.

Những con chip siêu lớn dùng trong trung tâm dữ liệu, có 80 tỷ bóng bán dẫn, gấp 5 lần con chip silicon chạy trên những iPhone đời mới nhất. Mặc dù đắt gấp đôi so với người tiền nhiệm A100 (ra mắt năm 2020), song những người dùng H100 nói rằng con chip này có hiệu suất gấp 3 lần.

H100 tỏ ra đặc biệt phổ biến với các “Big Tech” như Microsoft và Amazon, những công ty đang xây dựng toàn bộ trung tâm dữ liệu tập trung vào khối lượng công việc AI và các công ty khởi nghiệp AI thế hệ mới như OpenAI, Anthropic, Stability AI và Inflection AI vì nó hứa hẹn hiệu suất cao hơn, từ đó có thể tăng tốc độ ra mắt sản phẩm hoặc giảm chi phí đào tạo theo thời gian.

“Đây là một trong những nguồn tài nguyên kỹ thuật khan hiếm nhất hiện tại”, Brannin McBee, Giám đốc chiến lược và người sáng lập CoreWeave - startup đám mây dựa trên AI, cũng là một trong những công ty đầu tiên nhận lô hàng H100 vào đầu năm nay cho biết.

Một số khách hàng khác không may mắn như CoreWeave khi phải đợi tới 6 tháng mới có thể nhận sản phẩm để huấn luyện những mô hình dữ liệu siêu khổng lồ của họ. Nhiều startup AI lo ngại Nvidia không thể cung ứng đủ nhu cầu thị trường.

Elon Musk cũng đặt mua hàng nghìn con chip Nvidia cho công ty khởi nghiệp AI của mình, nói rằng “GPU hiện tại còn khó kiếm hơn cả thuốc phiện”.

“Các chi phí điện toán đã tăng nhanh chóng mặt. Số tiền tối thiểu phải bỏ ra cho phần cứng máy chủ dùng trong xây dựng AI sáng tạo đã lên tới 250 triệu USD”, CEO Tesla chia sẻ.

Nếu như H100 xuất hiện đúng thời điểm, thì sự đột phá của Nvidia về AI bắt nguồn từ hai thập kỷ trước nhờ đổi mới về phần mềm thay vì phần cứng. Năm 2006, công ty ra mắt phần mềm Cuda, cho phép tận dụng GPU làm công cụ tăng tốc những tác vụ ngoài đồ hoạ.

“Nvidia đã thấy tương lai trước những người khác và xoay trục phát triển GPU có thể lập trình. Công ty này phát hiện ra cơ hội, đặt cược lớn và liên tục vượt xa đối thủ cạnh tranh của mình”, Nathan Benaich, đối tác tại Air Street Capital và là nhà đầu tư vào startup AI, nhận định.

(Theo Reuters, FT)

Nguồn

![[Ảnh] Lan toả niềm đam mê khoa học-kỹ thuật trong môi trường giáo dục](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/27/059521b98e3847368f5ff4120460a500)

![[Ảnh] Người dân Thành phố Hồ Chí Minh trắng đêm chờ xem Lễ tổng duyệt diễu binh, diễu hành](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/27/0c555ae2078749f3825231e5b56b0a75)

![[Ảnh] Giới trẻ xếp hàng đón nhận phụ san đặc biệt kỷ niệm 50 năm Giải phóng miền Nam của Báo Nhân Dân](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/26/9e7e624ae81643eba5f3cdc232cd07a5)

Bình luận (0)