|

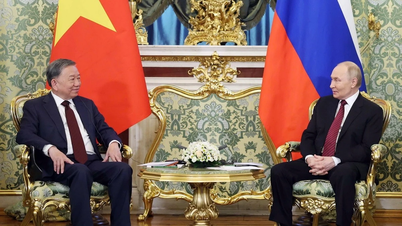

| Le président russe Vladimir Poutine. (Source : Reuters) |

Le 5 juin, le Kremlin a publié une annonce urgente indiquant qu'un clip vidéo du président russe Vladimir Poutine diffusé sur de nombreuses stations de radio et de télévision dans les régions frontalières de l'Ukraine était un deepfake créé par des pirates informatiques.

Fausse vidéo, impact réel

Dans son discours, la voix du président russe Vladimir Poutine, créée par la technologie deepfake, a déclaré que l'état d'urgence avait été déclaré dans les régions russes de Belgorod, Voronej et Rostov en raison d'attaques imminentes des forces ukrainiennes. Le faux Poutine a également demandé aux habitants des régions d’évacuer leurs maisons pour trouver refuge plus profondément à l’intérieur de la Russie.

| Deepfake est une technologie qui utilise l'intelligence artificielle (IA) pour prendre l'image et la voix d'une personne et les coller dans la vidéo d'une autre personne. La technologie Deepfake collecte une image du visage d'un sujet, puis remplace ce visage par le visage d'une autre personne dans une vidéo. Pour les fichiers audio, les deepfakes utilisent l'enregistrement vocal d'une personne réelle pour entraîner un ordinateur à parler exactement comme cette personne. |

Radio Mir , l'une des stations piratées, a déclaré que l'incident a duré environ 40 minutes. Entre-temps, des clips télévisés de fausses vidéos de M. Poutine ont également commencé à se propager sur les réseaux sociaux. Aucun individu ni aucune agence n’a encore revendiqué la responsabilité de cet incident.

Après que la vidéo soit devenue virale, le porte-parole du Kremlin, Dmitri Peskov, a affirmé que la déclaration de la loi martiale était l'œuvre de pirates informatiques.

« Il n'y a absolument aucune déclaration de loi martiale. Il y a effectivement eu des piratages informatiques dans certaines régions. On m'a signalé un incident de piratage sur Radio Mir et sur d'autres chaînes. Tous les pirates ont été éliminés et les chaînes d'information sont à nouveau sous contrôle », a déclaré Dmitri Peskov à l'agence de presse russe TASS.

Le Kyiv Post a également rapporté que le centre administratif de la région de Belgorod a qualifié le message vidéo de deepfake visant à « instiller la peur parmi les habitants pacifiques de Belgorod ».

Hanna Liubakova, journaliste biélorusse et chercheuse non résidente à l'Atlantic Council, a partagé un clip télévisé montrant une fausse image de M. Poutine.

En évaluant l'incident, le scientifique des données Arseny Khakhalin, expert en intelligence artificielle (IA), a déclaré que ce piratage pourrait être typique de l'utilisation du deepfake pour militariser le conflit russo-ukrainien.

Ce n’est cependant pas la première fois que la technologie deepfake est utilisée dans ce conflit. Au cours des premières semaines de l'opération militaire spéciale russe en février 2022, une vidéo deepfake du président ukrainien Volodymyr Zelensky a été diffusée. Dans la vidéo deepfake, M. Zelensky semble exhorter ses soldats à déposer les armes et à se rendre. La vidéo a été rapidement supprimée, mais elle était déjà devenue virale sur les réseaux sociaux.

|

| En matière de propagande, la technologie deepfake a un effet militaire ou politique convaincant, c'est une arme qui peut avoir un impact énorme. (Source : socialmediasafety) |

La nouvelle arme populaire

Le colonel Philip Ingram, ancien officier du renseignement militaire britannique et responsable politique de l'Organisation du traité de l'Atlantique Nord (OTAN), a déclaré à Politico Europe à propos de l'usurpation d'identité de Poutine que les publications deepfake prétendument créées à partir de données réelles constituent un risque croissant dans un monde influencé par l'IA.

Selon cette personne, dans la propagande, la technologie deepfake apporte des effets militaires ou politiques convaincants, c'est une arme qui peut avoir un impact énorme.

« Je soupçonne qu’il s’agit d’une nouvelle arme de prolifération », a ajouté le colonel Philip Ingram. Il a cité l'exemple d'il y a quelques semaines, lorsqu'une fausse photo de l'attentat du Pentagone est devenue virale sur Twitter, provoquant une chute de 500 milliards de dollars du marché boursier avant de se redresser.

Le professeur Hany Farid de l'Université de Californie à Berkeley (USA), expert en médias numériques, a averti qu'il ne fallait pas être surpris par de telles choses dans le contexte actuel où les gens construisent et déploient des outils pour manipuler la réalité combinés à des canaux médiatiques tels que la télévision, la radio, Internet... qui peuvent avoir un impact immédiat sur des milliards de dollars. De nombreux acteurs ayant des objectifs différents abuseront de ces technologies.

« Cela est particulièrement vrai lorsque nos régulateurs n’ont pas cherché à fournir des protections adéquates au secteur technologique, alors que la Silicon Valley continue de croître rapidement et de perturber les choses », a souligné le professeur Hany Farid.

Source

![[Photo] Prêt pour les plus grandes compétitions de tennis de table vietnamien](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/18/9c547c497c5a4ade8f98c8e7d44f5a41)

![[Photo] Les dirigeants du Parti et de l'État assistent au programme artistique spécial « Vous êtes Ho Chi Minh »](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/18/6895913f94fd4c51aa4564ab14c3f250)

![[Photo] De nombreux jeunes ont patiemment fait la queue sous le soleil brûlant pour recevoir un supplément spécial du journal Nhan Dan.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/18/6f19d322f9364f0ebb6fbfe9377842d3)

Comment (0)