Lundi, le bureau du procureur général du New Hampshire a annoncé qu'il lançait une enquête sur une possible manipulation des électeurs. Cette décision fait suite à des plaintes concernant une fausse voix, ressemblant à celle du président américain Joe Biden, exhortant les électeurs à ne pas voter lors des primaires de l'État.

Les chercheurs ont également mis en garde contre l’utilisation de faux fichiers audio pour imiter des hommes politiques et des dirigeants, des cas importants s’étant produits en 2023 au Royaume-Uni, en Inde, au Nigéria, au Soudan, en Éthiopie et en Slovaquie.

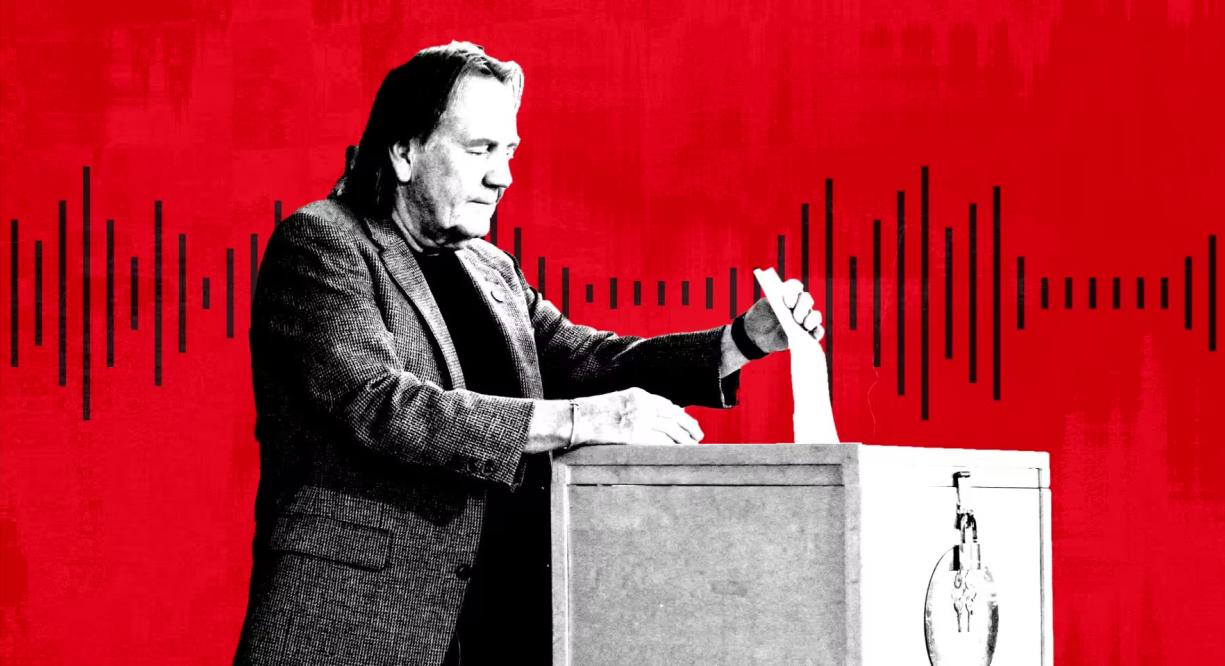

Une personne vote aux élections primaires dans le New Hampshire, aux États-Unis. Photo : Getty

Selon les experts, le deepfake audio est devenu une forme populaire de désinformation en raison de l'émergence d'une gamme d'outils d'IA bon marché et efficaces proposés par les startups. Microsoft a également développé un nouveau modèle d’IA capable de reproduire une voix à partir de seulement trois secondes d’enregistrement.

« En matière de manipulation visuelle, tout le monde connaît Photoshop ou du moins sait qu’il existe », a déclaré Henry Ajder, expert en IA et en deepfake et consultant auprès d’Adobe, Meta et EY. Il y a très peu de connaissances sur la façon dont l'audio peut être manipulé, donc pour moi, cela nous rend vraiment vulnérables.

En septembre, NewsGuard, un système qui évalue la qualité et la fiabilité des sites d’information, a découvert un réseau de comptes TikTok se faisant passer pour des sites d’information légitimes, utilisant du contenu généré par l’IA pour diffuser des théories du complot et de la désinformation politique. Les enregistrements audio deepfake, y compris celui de l'ancien président américain Barack Obama, ont attiré des centaines de millions de vues.

Les fausses voix off semblent avoir été générées par un outil fourni par ElevenLabs, soutenu par Andreessen Horowitz, tandis que les clips ont recueilli des centaines de millions de vues, a déclaré NewsGuard.

« Plus de 99 % des utilisateurs de notre plateforme créent du contenu intéressant, créatif et utile, mais nous reconnaissons qu'il existe des cas d'utilisation abusive et nous avons continuellement développé et introduit des protections pour les limiter », a déclaré ElevenLabs.

ElevenLabs, fondée il y a deux ans par d'anciens employés de Google et de Palantir, Piotr Dabkowski et Mati Staniszewski, propose gratuitement des outils rudimentaires de génération audio d'IA en un seul clic. Les forfaits d'abonnement varient de 1 $ par mois à 330 $ par mois et plus pour ceux qui recherchent des services plus complexes.

L’année dernière, les agences de renseignement américaines ont averti dans un rapport que « les escroqueries liées à l’IA personnalisée ont considérablement augmenté en raison de la publication de modèles de clonage vocal d’IA sophistiqués et bien entraînés ».

Outre les escroqueries à motivation financière, les experts politiques tirent désormais la sonnette d'alarme au sujet des clips audio deepfakes viraux ainsi que de l'utilisation de deepfakes pour des appels automatisés ou des campagnes. « Vous pouvez créer une campagne de désinformation puissante et généralisée en ciblant les téléphones », a déclaré AJ Nash, vice-président et éminent chercheur en renseignement au sein du groupe de cybersécurité ZeroFox.

Certaines de ces entreprises ont cherché de manière proactive d’autres moyens de lutter contre la désinformation. Microsoft a publié une déclaration d'éthique, exhortant les utilisateurs à signaler toute utilisation abusive de son moteur audio IA. ElevenLabs a construit ses propres outils de détection pour identifier les enregistrements générés par son système.

Lors des élections nigérianes de 2023, un clip manipulé par l'IA est devenu viral sur les réseaux sociaux, « suggérant prétendument qu'un candidat de l'opposition prévoyait de truquer le vote », selon le groupe de défense des droits humains Freedom House.

En Slovaquie, un faux enregistrement audio du candidat de l'opposition Michal Šimečka, apparemment en train de comploter pour truquer les élections, est devenu viral quelques jours avant l'élection présidentielle du pays en septembre.

« Le deepfake du New Hampshire nous rappelle les nombreuses façons dont les deepfakes peuvent induire en erreur et tromper », a déclaré Robert Weissman, président du groupe de défense des consommateurs à but non lucratif Public Citizen. Le moment des deepfakes politiques est venu. Les décideurs politiques doivent agir rapidement pour mettre en place des mesures de protection, sinon nous serons confrontés à un chaos électoral.

Mai Anh (selon le FT)

Source

![[Photo] Le Premier ministre Pham Minh Chinh préside une conférence gouvernementale avec les localités sur la croissance économique](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/2/21/f34583484f2643a2a2b72168a0d64baa)

Comment (0)