Comment fonctionnent les fausses images d’IA ?

L’IA est partout aujourd’hui, même en temps de guerre. Les applications d’intelligence artificielle se sont beaucoup améliorées cette année, et presque tout le monde peut utiliser des générateurs d’IA pour créer des images qui semblent réalistes, du moins à première vue.

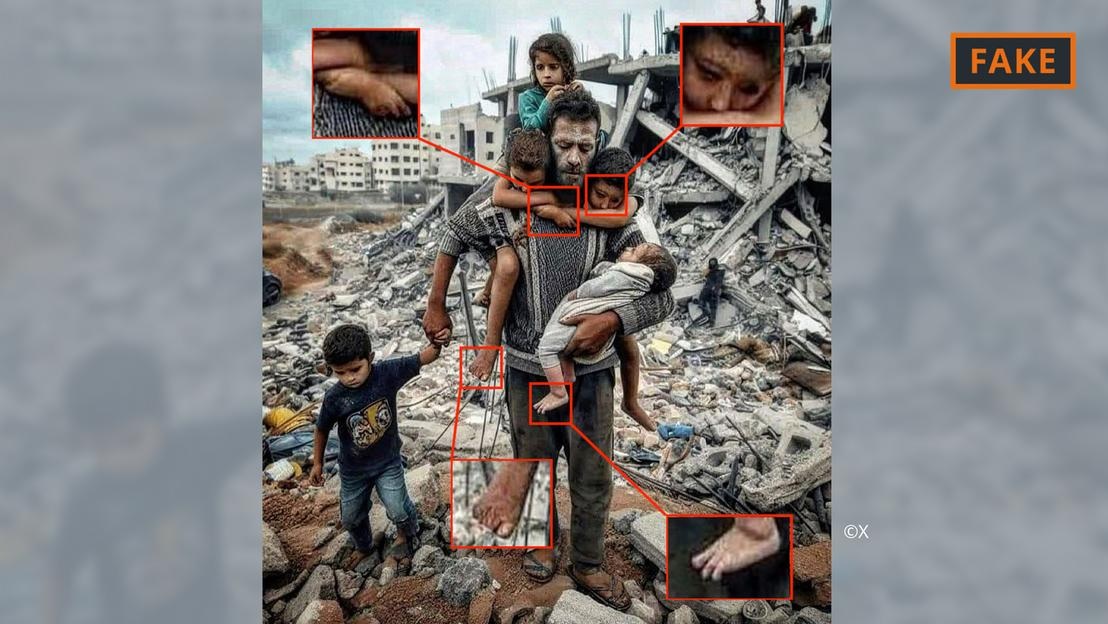

Une fausse photo générée par l'IA de la guerre à Gaza.

Pour ce faire, les utilisateurs doivent simplement donner quelques conseils à des outils comme Midjourney ou Dall-E, notamment des spécifications et des informations. Les outils d’IA convertissent ensuite le texte, voire la voix, en images.

Ce processus de génération d’images est basé sur ce que l’on appelle l’apprentissage automatique. Par exemple, si le créateur demande de montrer un homme de 70 ans faisant du vélo, il recherchera dans sa base de données pour faire correspondre les termes avec l'image.

Sur la base des informations disponibles, l’algorithme d’IA générera une image du cycliste âgé. Grâce à des apports et des mises à jour techniques toujours plus nombreux, ces outils se sont considérablement améliorés et sont en constante évolution.

Tout cela s’applique aux images liées au conflit au Moyen-Orient. Dans un conflit où « les émotions sont très fortes », la désinformation, y compris celle diffusée par l’imagerie de l’IA, a un impact énorme, a déclaré l’expert en IA Hany Farid.

Farid, professeur d'analyse numérique à l'Université de Californie à Berkeley, a déclaré que les batailles féroces sont le terrain idéal pour créer et diffuser de faux contenus, ainsi que pour attiser les émotions.

Images de l'IA de la guerre entre Israël et le Hamas

Les images et vidéos créées à l’aide de l’intelligence artificielle ont alimenté la désinformation liée à la guerre en Ukraine, et cela continue de se produire dans la guerre entre Israël et le Hamas.

Selon les experts, les images d’IA circulant sur les réseaux sociaux à propos de la guerre se répartissent souvent en deux catégories. Un film qui se concentre sur la souffrance des gens et suscite l’empathie. L’autre est une fausse IA qui exagère les événements, incitant ainsi au conflit et à l’escalade de la violence.

Photo truquée générée par l'IA d'un père et de son enfant dans les décombres à Gaza.

Par exemple, la première catégorie comprend la photo ci-dessus d’un père avec ses cinq enfants devant un tas de décombres. Il a été partagé plusieurs fois sur X (anciennement Twitter) et Instagram, vu des centaines de milliers de fois.

Cette image a été signalée par la communauté, au moins sur X, comme fausse. On peut le reconnaître à diverses erreurs et incohérences que l’on retrouve couramment dans les images d’IA (voir l’image ci-dessus).

Des anomalies similaires peuvent également être observées dans la fausse image d'IA devenue virale sur X ci-dessous, qui prétend montrer une famille palestinienne mangeant ensemble sur les ruines.

Photo falsifiée générée par l'IA d'un parti palestinien.

Pendant ce temps, une autre image montrant des soldats agitant des drapeaux israéliens alors qu'ils défilent dans une colonie remplie de maisons bombardées tombe dans la deuxième catégorie, conçue pour attiser la haine et la violence.

D’où viennent ces images d’IA ?

La plupart des images de conflit générées par l’IA sont publiées sur les plateformes de médias sociaux, mais elles sont également disponibles sur un certain nombre d’autres plateformes et organisations, et même sur certains sites d’information.

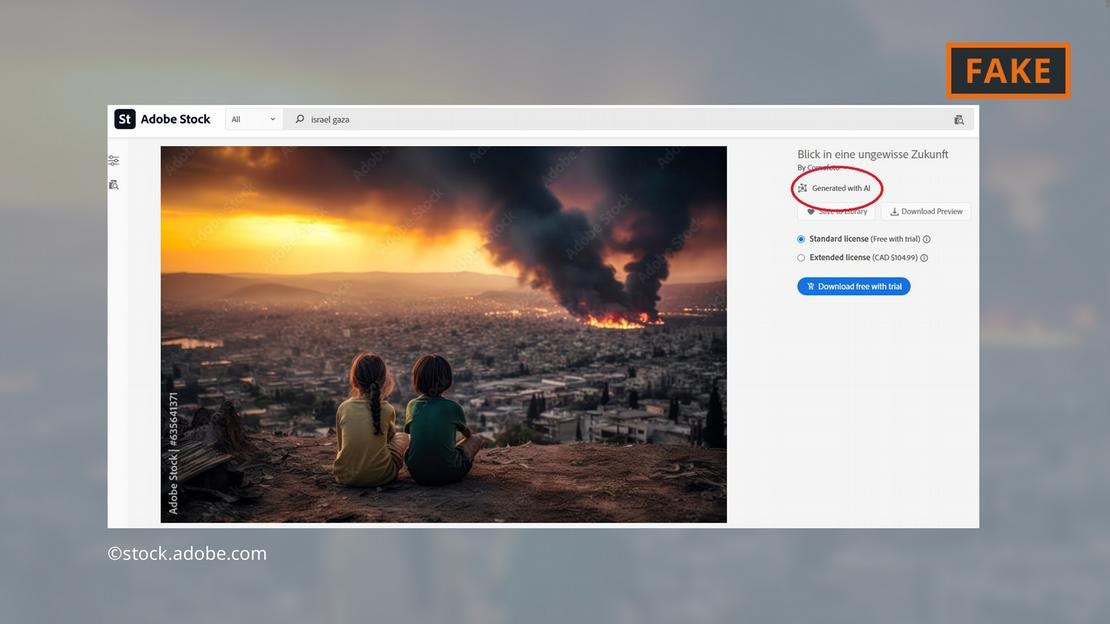

La société de logiciels Adobe a fait sensation en ajoutant des images générées par l'IA à sa gamme de photos d'archives d'ici la fin de 2022. Elles sont étiquetées en conséquence dans la base de données.

Adobe propose désormais également à la vente des images IA de la guerre au Moyen-Orient, comme des explosions, des manifestants ou des panaches de fumée derrière la mosquée Al-Aqsa.

Adobe propose des images générées par l'IA des combats à Gaza.

Les critiques ont trouvé cela dérangeant, car certains sites ont continué à utiliser les images sans les étiqueter comme générées par l’IA. Par exemple, l’image ci-dessus est apparue sur la page « Newsbreak » sans aucune indication qu’elle a été générée à l’aide de l’IA.

Même le Service de recherche du Parlement européen, la branche scientifique du Parlement européen, a illustré un document en ligne sur le conflit au Moyen-Orient avec une image d’IA provenant de la base de données Adobe — sans l’étiqueter comme générée par l’IA.

L'Observatoire européen des médias numériques exhorte les journalistes et les professionnels des médias à être extrêmement prudents lorsqu'ils utilisent des images d'IA, déconseillant leur utilisation, en particulier lorsqu'ils couvrent des événements réels tels que la guerre à Gaza.

À quel point les images IA sont-elles dangereuses ?

Le contenu et les images viraux de l’IA rendent les utilisateurs mal à l’aise face à tout ce qu’ils rencontrent en ligne. « Si nous entrons dans un monde où les images, les sons et les vidéos peuvent être manipulés, tout devient suspect. On perd alors foi en tout, y compris en la vérité », explique Farid, chercheur à l'UC Berkeley.

C'est exactement ce qui s'est passé dans le cas suivant : une image de ce qui serait le cadavre carbonisé d'un bébé israélien a été partagée sur les réseaux sociaux par le Premier ministre israélien Benjamin Netanyahu et plusieurs autres hommes politiques.

Un influenceur anti-israélien, Jackson Hinkle, a affirmé plus tard que l'image avait été créée à l'aide de l'intelligence artificielle. La déclaration de Hinkle a été vue plus de 20 millions de fois sur les réseaux sociaux et a suscité un débat houleux sur la plateforme.

En fin de compte, de nombreuses organisations et outils de vérification ont déclaré que l'image était réelle et que l'affirmation de Hinkle était fausse. Cependant, il n’existe clairement aucun outil qui puisse aider les utilisateurs à regagner facilement leur confiance perdue !

Hoang Hai (selon DW)

Source

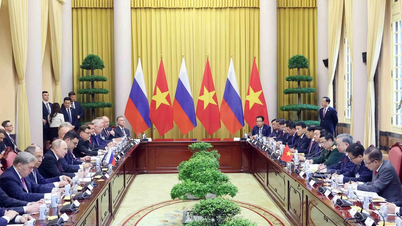

![[Photo] Le secrétaire général To Lam entame une visite officielle en Russie et assiste au 80e anniversaire de la victoire sur le fascisme](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/5d2566d7f67d4a1e9b88bc677831ec9d)

![[Photo] Le Secrétaire général conclut sa visite en Azerbaïdjan et se rend en Fédération de Russie](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

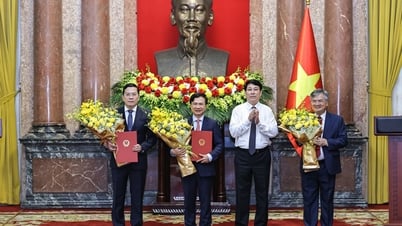

![[Photo] Le président Luong Cuong présente la décision de nommer le chef adjoint du cabinet du président](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/501f8ee192f3476ab9f7579c57b423ad)

![[Photo] Le président de l'Assemblée nationale, Tran Thanh Man, préside la réunion du sous-comité des documents du premier congrès du Parti de l'Assemblée nationale](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/72b19a73d94a4affab411fd8c87f4f8d)

![[Photo] Le Premier ministre Pham Minh Chinh rencontre le Conseil consultatif politique sur le développement économique privé](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

![[Photo] Le Premier ministre Pham Minh Chinh s'entretient au téléphone avec le Premier ministre singapourien Lawrence Wong](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

Comment (0)