A continuación se presentan las opiniones de dos expertos de la Universidad RMIT sobre los efectos nocivos de los deepfakes y las soluciones propuestas a este problema:

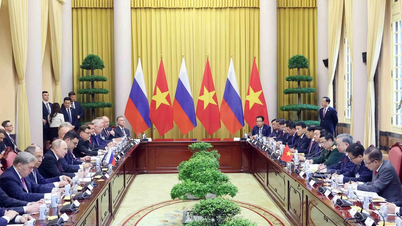

|

| Dr. Jonathan Crellin (izquierda) y Dr. Nguyen Van Thang Long (derecha). (Fuente: Universidad RMIT) |

Los ciberdelincuentes explotan las nuevas tecnologías de formas imprevistas

Dr. Jonathan Crellin, Jefe de Seguridad de la Información, Facultad de Ciencias, Ingeniería y Tecnología, Universidad RMIT :

Deepfake es una imagen generada por máquina que puede combinar imágenes o vídeos de múltiples fuentes, creando una imagen, un vídeo o incluso un audio muy realista.

Los deepfakes se basan en una técnica de IA llamada aprendizaje automático, que puede reemplazar e integrar elementos como el rostro de una persona en otra imagen o vídeo.

Un ejemplo del uso de deepfake es la combinación de contenido pornográfico con fotos de Taylor Swift para crear imágenes falsas.

Para ello, el cerebro necesitaba algunas imágenes para que el software pudiera conocer las expresiones faciales de la cantante y luego combinarlas con contenido pornográfico para crear fotos obscenas, provocando que la imagen de la cantante se viera empañada.

De hecho, se rumorea que estas fotos fueron publicadas por un grupo de Telegram y fueron creadas utilizando la herramienta Microsoft Designer con soporte de IA integrado.

Cualquiera puede convertirse en víctima, ya que los malos sólo necesitan una fotografía, un vídeo o una grabación de audio de la persona suplantada.

Las noticias falsas en muchas formas tienen el potencial de ser utilizadas para crear noticias falsas, y es seguro asumir que las próximas elecciones presidenciales de EE. UU. estarán llenas de esas noticias falsas.

Actualmente, legisladores de todo el mundo están buscando promulgar leyes contra este tipo de imágenes.

En Estados Unidos se están empezando a adoptar algunos enfoques en materia legislativa, como recurrir a demandas civiles o leyes para abordar “la difusión de imágenes sexualmente explícitas de una persona generadas por IA sin el consentimiento de esa persona”.

China también introdujo nuevas regulaciones que permitirían enjuiciar a quienes difundan imágenes generadas por IA.

El Reino Unido ha declarado ilegal compartir contenido deepfake según su ley de seguridad en línea.

¿Cómo detectar o prevenir esto?

La primera forma es reducir la cantidad de imágenes, vídeos o grabaciones de audio en línea. Asegúrate de compartirlos únicamente con personas que conoces y no de publicarlos ampliamente en línea. Una vez que el contenido se publica en Internet, es casi imposible eliminarlo.

La segunda forma es acordar una palabra secreta con tu familia para autenticar la llamada, reduciendo el riesgo de caer en la trampa de una llamada falsa.

Las imágenes, especialmente los vídeos, pueden tener errores extraños (que parecen manipulados); si detecta estos errores, existe una gran posibilidad de que la imagen o el sonido hayan sido falsificados.

Otra técnica que se puede utilizar es buscar “imagen inversa” en Google u otros motores de búsqueda, para determinar la fuente de la imagen original.

La lección final es no creer ciegamente lo que ves, ¡la cámara (o la IA) puede mentir!

Los deepfakes representan una gran amenaza para las celebridades y los políticos

Dr. Nguyen Van Thang Long, profesor titular, Facultad de Comunicación y Diseño, Universidad RMIT :

Con la proliferación de noticias falsas provenientes de deepfakes, los equipos de medios de celebridades y políticos necesitan tener recursos disponibles para monitorear y responder con rapidez a las noticias falsas o corregirlas continuamente.

Si los deepfakes se combinan sistemáticamente con formas organizadas de “relaciones públicas sucias”, esta tarea se vuelve aún más difícil debido a la proliferación de información contradictoria, y las noticias falsas y negativas siempre se compartirán más que las positivas.

Generalmente, al ver noticias compartidas en las redes sociales, los individuos suelen tener la costumbre de confirmar la información a través de los medios oficiales.

Dado que el contenido deepfake inunda las redes sociales, es cada vez más difícil y lleva más tiempo verificar la exactitud de las noticias principales, lo que requiere investigación en profundidad y técnicas de verificación.

Cuanto más demoremos en verificar las noticias y las fuentes, más probable será que se difunda información falsa, inventada o engañosa debido a la rápida velocidad con la que se comparten y comentan las redes sociales.

Esto agrava el problema subyacente y tiene el potencial de conducir al malestar social, especialmente si el contenido se relaciona con el discurso político, la religión, el género, la estrategia empresarial o cuestiones macroeconómicas.

En el contexto de la proliferación de deepfakes, la estrategia de gestión de riesgos más eficaz sigue siendo mantener canales de comunicación consistentes, a través de plataformas de redes sociales populares, sitios web o reuniones cara a cara, entre empresas, celebridades, políticos y partes interesadas clave como fanáticos, prensa, comunidades y empleados.

|

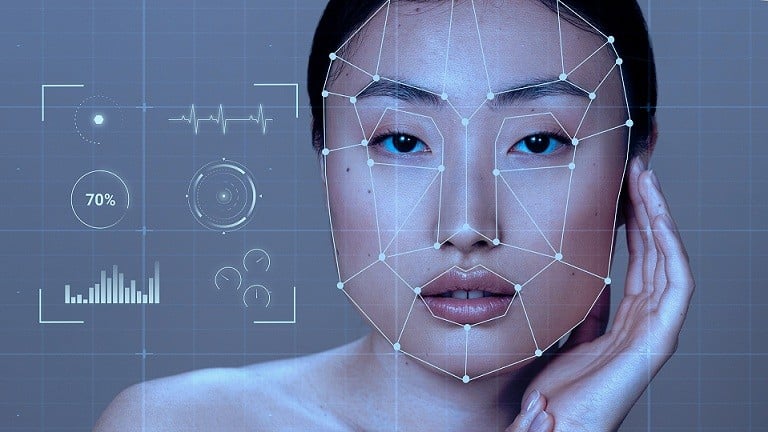

El mayor uso de la IA trae consigo beneficios pero también nuevos problemas inesperados. Foto ilustrativa. (Fuente: Freepik) |

Al mantener estos canales de comunicación, la recepción de información relacionada con deepfakes se vuelve más rápida, lo que permite una corrección oportuna y efectiva de los rumores, exponiendo la información errónea desde el principio.

Sin embargo, las empresas, las celebridades y los políticos necesitan idear escenarios de gestión de crisis específicos para los deepfakes. Por ejemplo, quién hizo el anuncio, a través de qué medios de comunicación, los criterios para verificar la información mediante evidencia y fuentes confiables, establecer un cronograma para resolver los rumores y delinear una estrategia para restaurar la reputación.

Con un plan bien preparado y metódico, manejar una crisis de deepfake será más factible, minimizando posibles consecuencias desafortunadas.

[anuncio_2]

Fuente

![[Foto] El Secretario General concluye su visita a Azerbaiyán y parte hacia la Federación Rusa.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, preside la reunión del Subcomité de Documentos del Primer Congreso del Partido de la Asamblea Nacional.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/72b19a73d94a4affab411fd8c87f4f8d)

![[Foto] El primer ministro Pham Minh Chinh se reúne con el Consejo Asesor de Políticas sobre Desarrollo Económico Privado](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

![[Foto] El presidente Luong Cuong presenta la decisión de nombrar al subdirector de la Oficina del Presidente.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/501f8ee192f3476ab9f7579c57b423ad)

![[Foto] El primer ministro Pham Minh Chinh habla por teléfono con el primer ministro de Singapur, Lawrence Wong.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

Kommentar (0)