¿Cómo funcionan las imágenes falsas de IA?

Hoy en día, la IA está en todas partes, incluso en la guerra. Las aplicaciones de inteligencia artificial han mejorado mucho este año y casi cualquiera puede usar generadores de IA para crear imágenes que parezcan realistas, al menos a primera vista.

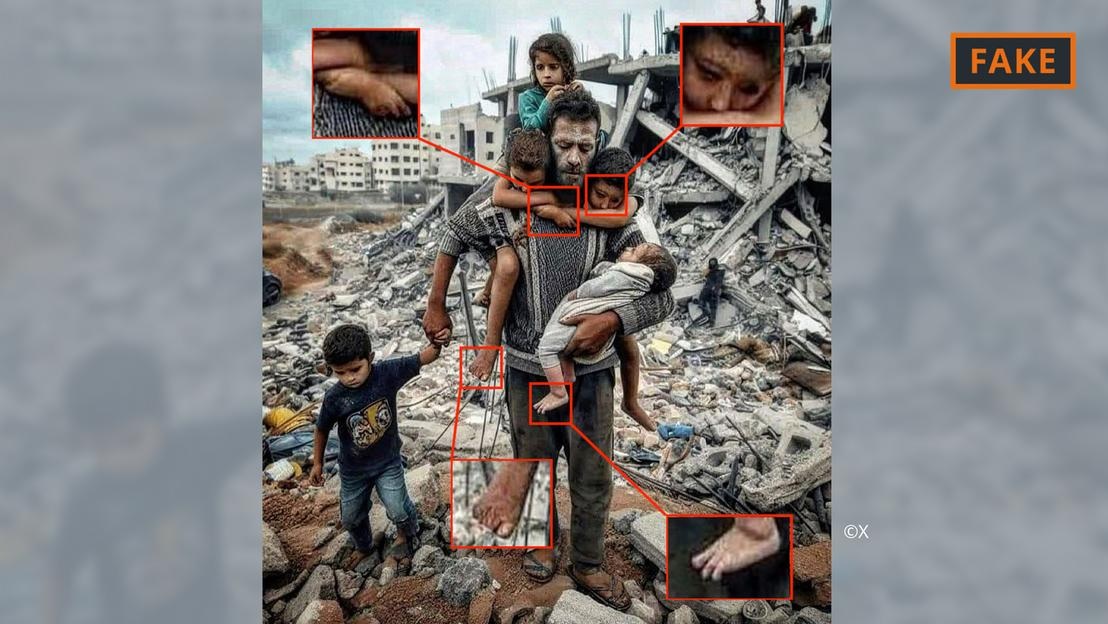

Una fotografía falsa generada por inteligencia artificial de la guerra en Gaza.

Para ello, los usuarios solo tienen que dar algunas pistas, incluidas especificaciones e información, a herramientas como Midjourney o Dall-E. Las herramientas de inteligencia artificial luego convierten las indicaciones de texto, o incluso de voz, en imágenes.

Este proceso de generación de imágenes se basa en lo que se conoce como aprendizaje automático. Por ejemplo, si el creador pide mostrar a un hombre de 70 años montando en bicicleta, buscará en su base de datos para hacer coincidir los términos con la imagen.

Basándose en la información disponible, el algoritmo de IA generará una imagen del ciclista mayor. Gracias a cada vez más aportaciones y actualizaciones técnicas, estas herramientas han mejorado notablemente y están aprendiendo constantemente.

Todo esto se está aplicando a imágenes relacionadas con el conflicto en Oriente Medio. En un conflicto donde “las emociones están muy a flor de piel”, la desinformación, incluida la difundida mediante imágenes de IA, tiene un enorme impacto, afirmó el experto en IA Hany Farid.

Farid, profesor de análisis digital en la Universidad de California en Berkeley, dijo que las batallas feroces son el caldo de cultivo perfecto para crear y difundir contenido falso, además de avivar las emociones.

Imágenes de IA de la guerra entre Israel y Hamás

Las imágenes y vídeos creados con la ayuda de inteligencia artificial han alimentado la desinformación relacionada con la guerra en Ucrania, y eso sigue sucediendo en la guerra entre Israel y Hamás.

Según los expertos, las imágenes de IA sobre la guerra que circulan en las redes sociales a menudo se dividen en dos categorías. Uno que se centra en el sufrimiento de las personas y evoca empatía. La otra es una IA falsa que exagera los acontecimientos, incitando así al conflicto y aumentando la violencia.

Fotografía falsa generada por inteligencia artificial de padre e hijo entre los escombros en Gaza.

Por ejemplo, la primera categoría incluye la foto de arriba de un padre con sus cinco hijos frente a una pila de escombros. Fue compartido varias veces en X (antes Twitter) e Instagram y fue visto cientos de miles de veces.

Esta imagen ha sido marcada por la comunidad, al menos en X, como falsa. Se puede reconocer por varios errores e inconsistencias que se encuentran comúnmente en las imágenes de IA (ver imagen de arriba).

También se pueden ver anomalías similares en la imagen falsa de IA que se volvió viral en X a continuación, que pretende mostrar a una familia palestina comiendo junta en las ruinas.

Fotografía falsa de un partido palestino generada por inteligencia artificial.

Mientras tanto, otra imagen que muestra a tropas ondeando banderas israelíes mientras marchan a través de un asentamiento lleno de casas bombardeadas cae en la segunda categoría, diseñada para incitar al odio y la violencia.

¿De dónde proceden estas imágenes de IA?

La mayoría de las imágenes de conflictos generadas por IA se publican en plataformas de redes sociales, pero también están disponibles en otras plataformas y organizaciones, e incluso en algunos sitios de noticias.

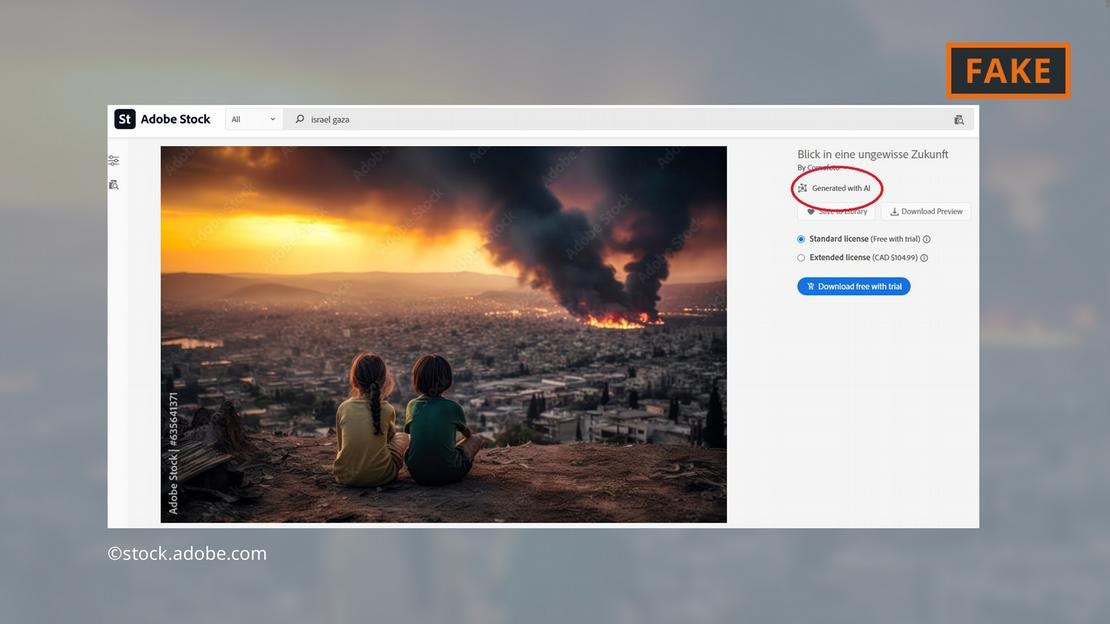

La empresa de software Adobe ha causado sensación al añadir imágenes generadas por IA a su catálogo de fotografías de archivo para finales de 2022. Estas imágenes estarán etiquetadas como corresponde en la base de datos.

Adobe también ofrece ahora a la venta imágenes de inteligencia artificial de la guerra en Oriente Medio, como explosiones, personas protestando o columnas de humo detrás de la mezquita Al-Aqsa.

Adobe ofrece imágenes generadas por inteligencia artificial de los combates en Gaza.

Los críticos encontraron esto inquietante ya que algunos sitios continuaron usando las imágenes sin etiquetarlas como generadas por IA. Por ejemplo, la imagen de arriba apareció en la página “Newsbreak” sin ninguna indicación de que fue generada usando IA.

Incluso el Servicio de Investigación del Parlamento Europeo, el brazo científico del Parlamento Europeo, ilustró un documento en línea sobre el conflicto de Medio Oriente con una imagen de IA de la base de datos de Adobe, sin etiquetarla como generada por IA.

El Observatorio Europeo de Medios Digitales insta a los periodistas y profesionales de los medios a ser extremadamente cautelosos al utilizar imágenes de IA y desaconseja su uso, especialmente cuando cubren acontecimientos reales como la guerra en Gaza.

¿Qué tan peligrosas son las imágenes de IA?

El contenido y las imágenes virales de IA hacen que los usuarios se sientan incómodos con todo lo que encuentran en línea. “Si entramos en este mundo donde las imágenes, los sonidos y los vídeos pueden manipularse, todo se vuelve sospechoso. Así, se pierde la fe en todo, incluso en la verdad”, explica Farid, investigador de UC Berkeley.

Eso es exactamente lo que sucedió en el siguiente caso: una imagen de lo que se dijo que era el cadáver carbonizado de un bebé israelí fue compartida en las redes sociales por el primer ministro israelí, Benjamin Netanyahu, y varios otros políticos.

Un influencer antiisraelí, Jackson Hinkle, afirmó más tarde que la imagen fue creada utilizando inteligencia artificial. La declaración de Hinkle ha sido vista más de 20 millones de veces en las redes sociales y ha provocado un acalorado debate en la plataforma.

Finalmente, numerosas organizaciones y herramientas de verificación declararon que la imagen era real y la afirmación de Hinkle era falsa. Sin embargo, claramente no existe ninguna herramienta que pueda ayudar a los usuarios a recuperar fácilmente la confianza perdida.

Hoang Hai (según DW)

[anuncio_2]

Fuente

![[Foto] El Secretario General To Lam inicia una visita oficial a Rusia y asiste al 80º Aniversario de la Victoria sobre el Fascismo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/5d2566d7f67d4a1e9b88bc677831ec9d)

![[Foto] El primer ministro Pham Minh Chinh se reúne con el Consejo Asesor de Políticas sobre Desarrollo Económico Privado](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

Kommentar (0)