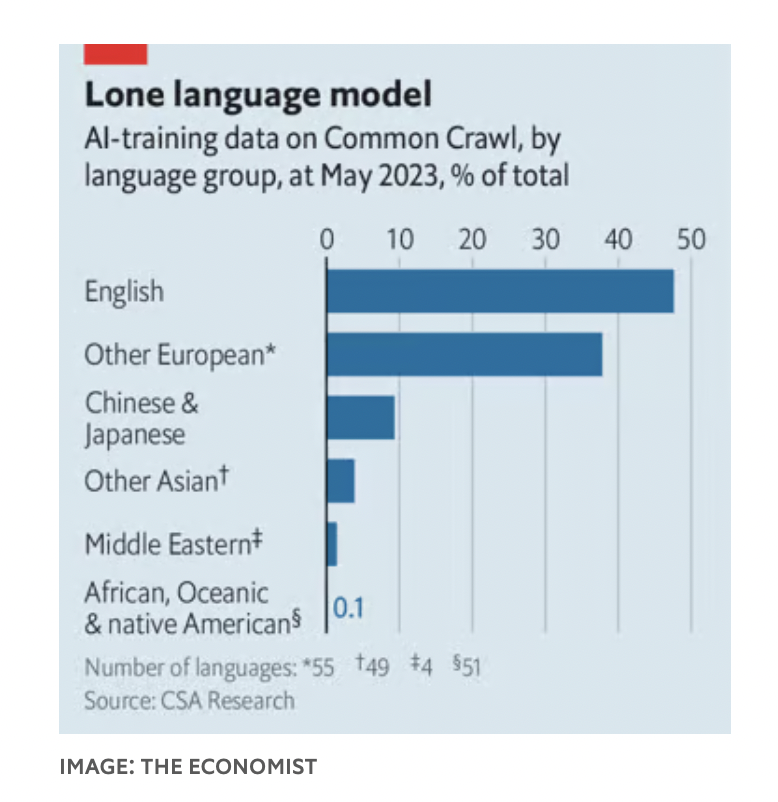

OpenAI hat nicht viel darüber verraten, wie ChatGPT-4 trainiert wurde. Normalerweise werden große Sprachmodelle (LLMs) jedoch anhand von Texten aus dem Internet trainiert, wo Englisch die Lingua Franca ist. Etwa 93 % der Trainingsdaten von ChatGPT-3 sind auf Englisch.

In Common Crawl, nur einem der Datensätze, mit denen das KI-Modell trainiert wird, macht Englisch 47 % des Korpus aus, andere europäische Sprachen machen weitere 38 % aus. Im Gegensatz dazu machen Chinesen und Japaner zusammen nur 9 % aus.

Eine Überprüfung durch Nathaniel Robinson, einen Forscher an der Johns Hopkins University, und seine Kollegen ergab, dass es sich nicht nur um ein auf ChatGPT beschränktes Problem handelte. Alle LLMs erzielen bei „ressourcenintensiven“ Sprachen, bei denen es reichlich Trainingsdaten gibt, eine bessere Leistung als bei „ressourcenarmen“ Sprachen, bei denen diese knapp sind.

Dies ist ein Problem für diejenigen, die KI in arme Länder bringen wollen, um dort Bereiche von der Bildung bis zur Gesundheitsversorgung zu verbessern. Daher arbeiten Forscher weltweit daran, KI mehrsprachiger zu machen.

Im vergangenen September hat die indische Regierung einen Chatbot eingeführt, der Landwirten hilft, mit nützlichen Informationen der Regierung auf dem Laufenden zu bleiben.

Shankar Maruwada von der EkStep Foundation, der gemeinnützigen Organisation, die beim Aufbau des Chatbots mitgewirkt hat, sagte, der Bot funktioniere durch die Kombination zweier Arten von Sprachmodellen und Benutzer könnten Anfragen in ihrer Muttersprache stellen. Diese Abfragen in der Muttersprache werden an eine maschinelle Übersetzungssoftware in einer indischen Forschungseinrichtung weitergeleitet, die sie ins Englische übersetzt und sie anschließend zur Verarbeitung der Antworten an LLM weiterleitet. Abschließend wird die Antwort wieder in die Muttersprache des Benutzers übersetzt.

Dieser Prozess funktioniert möglicherweise, aber die Übersetzung der Abfragen in die „bevorzugte“ Sprache des LLM ist eine umständliche Problemumgehung. Sprache ist ein Mittel, Kultur und Weltanschauung widerzuspiegeln. Eine Arbeit von Rebecca Johnson, einer Forscherin an der Universität Sydney, aus dem Jahr 2022 ergab, dass ChatGPT-3 Antworten zu Themen wie Waffenkontrolle und Flüchtlingspolitik lieferte, die mit den im World Values Survey zum Ausdruck gebrachten amerikanischen Werten vergleichbar waren.

Aus diesem Grund versuchen viele Forscher, LLMs die Fähigkeit zu vermitteln, auch weniger verbreitete Sprachen fließend zu beherrschen. Technisch gesehen besteht ein Ansatz darin, die Tokenisierung der Sprache zu ändern. Ein indisches Startup namens Sarvam AI hat einen für Hindi optimierten Tokenizer oder OpenHathi geschrieben – ein für die Devanagari-Sprache (indisch) optimiertes LLM-Modell, das den Aufwand für die Beantwortung von Fragen erheblich senken kann.

Eine andere Möglichkeit besteht darin, die Datensätze zu verbessern, mit denen LLM trainiert wird. Im November veröffentlichte ein Forscherteam der Mohamed bin Zayed University in Abu Dhabi die neueste Version eines arabischsprachigen Modells namens „Jais“. Es verfügt über ein Sechstel der Parameteranzahl von ChatGPT-3, bietet aber eine vergleichbare Leistung für Arabisch.

Timothy Baldwin, Kanzler der Mohamed bin Zayed University, stellte fest, dass sein Team zwar viele arabische Texte digitalisiert habe, das Modell jedoch immer noch einige englische Texte enthalte. Manche Konzepte sind in allen Sprachen gleich und können in jeder Sprache erlernt werden.

Der dritte Ansatz besteht darin, die Modelle nach dem Training zu optimieren. Sowohl Jais als auch OpenHathi verfügen über eine Reihe von von Menschen erstellten Frage- und Antwortpaaren. Dasselbe gilt für westliche Chatbots, um Fehlinformationen zu verhindern.

Für Ernie Bot, LLM bei Baidu, einem großen chinesischen Technologieunternehmen, wurden Vorschriften erlassen, um Äußerungen einzuschränken, die die Regierung beleidigen könnten. Modelle können auch aus menschlichem Feedback lernen, wenn Benutzer die Antworten von LLM bewerten. Dies ist jedoch für viele Sprachen in weniger entwickelten Regionen schwierig, da qualifizierte Mitarbeiter eingestellt werden müssen, um die Reaktion der Maschine beurteilen zu können.

(Laut Economist)

[Anzeige_2]

Quelle

![[Foto] Premierminister Pham Minh Chinh arbeitet mit dem Ständigen Ausschuss des Parteikomitees der Provinz Thai Binh zusammen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/12/f514ab990c544e05a446f77bba59c7d1)

![[Foto] Premierminister Pham Minh Chinh empfängt den schwedischen Minister für internationale Entwicklungszusammenarbeit und Außenhandel](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/12/ae50d0bb57584fd1bbe1cd77d9ad6d97)

![[Foto] Premierminister Pham Minh Chinh beginnt mit dem Bau einer wichtigen Autobahn durch Thai Binh und Nam Dinh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/12/52d98584ccea4c8dbf7c7f7484433af5)

Kommentar (0)