Am Montag gab das Büro des Generalstaatsanwalts von New Hampshire bekannt, dass es eine Untersuchung wegen möglicher Wahlmanipulation einleite. Zuvor hatte es Beschwerden über eine falsche Stimme gegeben, die identisch mit der von US-Präsident Joe Biden klang und die Wähler dazu aufforderte, bei den Vorwahlen des Bundesstaates nicht ihre Stimme abzugeben.

Forscher warnten außerdem vor der Verwendung von Deepfake-Audiodateien zur Nachahmung von Politikern und Staatsoberhäuptern. Prominente Fälle ereigneten sich 2023 in Großbritannien, Indien, Nigeria, Sudan, Äthiopien und der Slowakei.

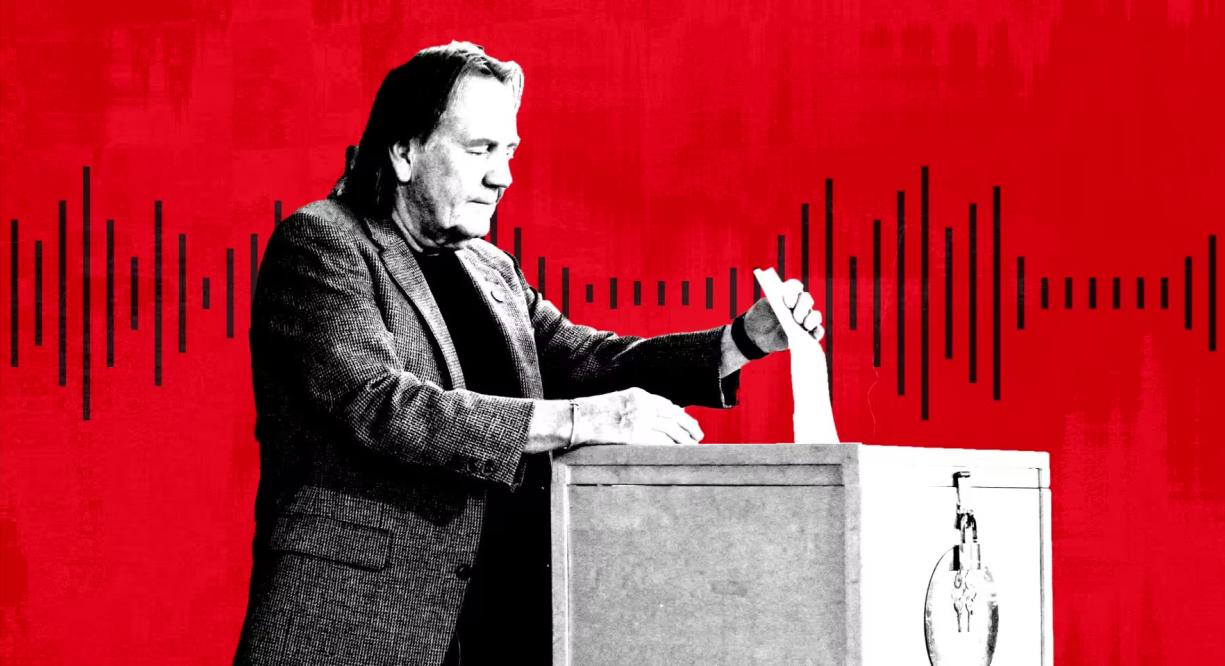

Eine Person nimmt an den Vorwahlen in New Hampshire, USA, teil. Foto: Getty

Deepfake-Audio ist aufgrund der Entstehung einer Reihe kostengünstiger und effektiver KI-Tools von Startups zu einer beliebten Form der Desinformation geworden, sagen Experten. Microsoft hat außerdem ein neues KI-Modell entwickelt, das eine Stimme anhand einer Aufnahme von nur drei Sekunden nachbilden kann.

„Wenn es um visuelle Manipulation geht, kennt jeder Photoshop oder weiß zumindest, dass es existiert“, sagte Henry Ajder, ein KI- und Deepfake-Experte und Berater von Adobe, Meta und EY. „Es gibt kaum ein Bewusstsein dafür, wie Audio manipuliert werden kann. Das macht uns meiner Meinung nach wirklich angreifbar.“

Im September entdeckte NewsGuard, ein System zur Bewertung der Qualität und Vertrauenswürdigkeit von Nachrichten-Websites, ein Netzwerk von TikTok-Konten, die sich als legitime Nachrichten-Websites ausgaben und mithilfe von KI-generierten Inhalten Verschwörungstheorien und politische Fehlinformationen verbreiteten. Deepfake-Audioaufnahmen, darunter die des ehemaligen US-Präsidenten Barack Obama, wurden Hunderte Millionen Mal angesehen.

Die gefälschten Voiceovers scheinen von einem Tool des von Andreessen Horowitz unterstützten Unternehmens ElevenLabs generiert worden zu sein, und die Clips wurden laut NewsGuard Hunderte Millionen Mal angesehen.

„Über 99 % der Benutzer auf unserer Plattform erstellen interessante, kreative und nützliche Inhalte, aber wir sind uns bewusst, dass es Fälle von Missbrauch gibt, und wir haben kontinuierlich Schutzmaßnahmen entwickelt und eingeführt, um diese einzuschränken“, sagte ElevenLabs.

ElevenLabs, vor zwei Jahren von den ehemaligen Google- und Palantir-Mitarbeitern Piotr Dabkowski und Mati Staniszewski gegründet, bietet rudimentäre KI-Tools zur Audiogenerierung kostenlos mit nur einem Klick an. Die Abonnements reichen von 1 USD pro Monat bis zu 330 USD pro Monat und mehr für diejenigen, die komplexere Dienste suchen.

Im vergangenen Jahr warnten US-Geheimdienste in einem Bericht, dass „personalisierte KI-Betrügereien aufgrund der Veröffentlichung hochentwickelter und gut trainierter KI-Modelle zum Klonen von Stimmen erheblich zugenommen haben“.

Neben finanziell motivierten Betrügereien schlagen politische Experten mittlerweile Alarm wegen viraler Deepfake-Audioclips sowie der Verwendung von Deepfakes für Robocalls oder Kampagnen. „Man kann eine wirkungsvolle, weitverbreitete Desinformationskampagne aufbauen, indem man auf Telefone zielt“, sagte AJ Nash, Vizepräsident und angesehener Geheimdienstmitarbeiter bei der Cybersicherheitsgruppe ZeroFox.

Einige dieser Unternehmen haben proaktiv nach anderen Wegen gesucht, um Fehlinformationen zu bekämpfen. Microsoft hat eine Ethikerklärung veröffentlicht, in der Benutzer aufgefordert werden, jeden Missbrauch seiner KI-Audio-Engine zu melden. ElevenLabs hat eigene Erkennungstools entwickelt, um die von seinem System generierten Aufzeichnungen zu identifizieren.

Während der Wahlen in Nigeria im Jahr 2023 verbreitete sich in den sozialen Medien ein mithilfe künstlicher Intelligenz manipulierter Clip, der „angeblich suggerierte, ein Oppositionskandidat plane, die Wahl zu manipulieren“, so die Menschenrechtsorganisation Freedom House.

In der Slowakei verbreitete sich nur wenige Tage vor der Präsidentschaftswahl im September eine gefälschte Audioaufnahme des Oppositionskandidaten Michal Šimečka, der offenbar plante, die Wahl zu manipulieren.

„Der Deepfake aus New Hampshire ist eine Erinnerung daran, auf welch vielfältige Weise Deepfakes verwirren und betrügen können“, sagte Robert Weissman, Präsident der gemeinnützigen Verbraucherschutzgruppe Public Citizen. „Der Moment des politischen Deepfakes ist gekommen. Die politischen Entscheidungsträger müssen schnell handeln und Sicherheitsvorkehrungen treffen, sonst droht uns Wahlchaos.“

Mai Anh (laut FT)

[Anzeige_2]

Quelle

Kommentar (0)