|

Bei den beiden neu eingeführten ChatGPT-Modellen ist die Häufigkeit der Informationsfälschung höher als bei der vorherigen Generation. Foto: Glühwürmchen . |

Nur zwei Tage nach der Ankündigung von GPT-4.1 hat OpenAI nicht nur ein, sondern gleich zwei neue Modelle namens o3 und o4-mini offiziell auf den Markt gebracht. Beide Modelle weisen überlegene Inferenzfähigkeiten mit vielen leistungsstarken Verbesserungen auf.

Allerdings leide dieses neue Modellduo laut TechCrunch noch immer unter „Halluzinationen“ bzw. selbst erfundenen Informationen. Sie „halluzinieren“ sogar mehr als einige der älteren Modelle von OpenAI.

Laut IBM liegen Halluzinationen vor, wenn ein großes Sprachmodell (LLM) – typischerweise ein Chatbot oder ein Computer-Vision-Tool – Datenmuster empfängt, die nicht existieren oder für Menschen nicht erkennbar sind, was zu bedeutungslosen oder irreführenden Ergebnissen führt.

Mit anderen Worten: Benutzer verlangen von der KI häufig, dass sie auf Grundlage der Trainingsdaten genaue Ergebnisse generiert. In einigen Fällen basieren die KI-Ergebnisse jedoch nicht auf genauen Daten, was zu „illusorischen“ Antworten führt.

In seinem jüngsten Bericht stellte OpenAI fest, dass o3 bei der Beantwortung von 33 % der Fragen bei PersonQA, dem internen Benchmark des Unternehmens zur Messung der Genauigkeit des Wissens eines Modells über Menschen, „halluzinierte“.

Zum Vergleich: Dies ist die doppelte „Halluzinationsrate“ der vorherigen Reasoning-Modelle von OpenAI, o1 und o3-mini, die 16 % bzw. 14,8 % betrugen. Das O4-Mini-Modell schnitt bei PersonQA sogar noch schlechter ab und erlebte während bis zu 48 % der Testdauer „Halluzinationen“.

Noch beunruhigender ist, dass der „Vater von ChatGPT“ nicht wirklich weiß, warum dies passiert. Im technischen Bericht zu o3 und o4-mini schreibt OpenAI insbesondere, dass „weitere Forschung erforderlich ist, um zu verstehen, warum die ‚Illusion‘ schlimmer wird“, wenn die Argumentationsmodelle skaliert werden.

Der o3 und der o4-mini schneiden in einigen Bereichen besser ab, darunter bei Programmier- und Mathematikaufgaben. Aufgrund der Notwendigkeit, „mehr Behauptungen aufzustellen als zu verallgemeinern“, leiden beide Modelle jedoch unter dem Problem, dass sie Ergebnisse produzieren, die „präzisere Behauptungen, aber auch ungenauere Behauptungen“ enthalten.

Quelle: https://znews.vn/canh-bao-ve-chatgpt-ao-giac-post1547242.html

![[Foto] Generalsekretär beendet Besuch in Aserbaidschan und bricht zu Besuch in die Russische Föderation auf](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

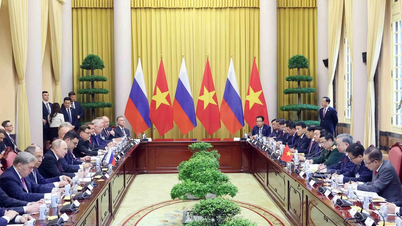

![[Foto] Generalsekretär To Lam beginnt offiziellen Besuch in Russland und nimmt an der Feier zum 80. Jahrestag des Sieges über den Faschismus teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/5d2566d7f67d4a1e9b88bc677831ec9d)

![[Foto] Premierminister Pham Minh Chinh trifft sich mit dem Policy Advisory Council on Private Economic Development](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

![[Foto] Der Vorsitzende der Nationalversammlung, Tran Thanh Man, leitet die Sitzung des Unterausschusses für Dokumente des ersten Parteitags der Nationalversammlung](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/72b19a73d94a4affab411fd8c87f4f8d)

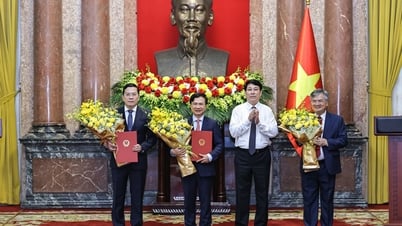

![[Foto] Präsident Luong Cuong präsentiert die Entscheidung zur Ernennung des stellvertretenden Leiters des Präsidialamtes](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/501f8ee192f3476ab9f7579c57b423ad)

![[Foto] Premierminister Pham Minh Chinh telefoniert mit dem singapurischen Premierminister Lawrence Wong](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

Kommentar (0)