(CLO) Công cụ chuyển giọng nói thành văn bản Whisper của OpenAI được quảng cáo là có "độ mạnh mẽ và chính xác gần bằng con người", nhưng có một nhược điểm lớn: Nó dễ bịa đặt ra các đoạn văn bản hoặc thậm chí là toàn bộ câu nói!

Theo các chuyên gia, một số văn bản nó bịa ra, trong ngành gọi là ảo giác, có thể bao gồm bình luận về chủng tộc, bạo lực và thậm chí là các phương pháp điều trị y tế tưởng tượng.

Các chuyên gia cho biết những bịa đặt như vậy rất nghiêm trọng vì Whisper đang được sử dụng trong rất nhiều ngành công nghiệp trên toàn thế giới để dịch và phiên âm các cuộc phỏng vấn, tạo văn bản và tạo phụ đề cho video.

Đáng lo ngại hơn là các trung tâm y tế đang sử dụng các công cụ dựa trên Whisper để ghi lại cuộc tư vấn giữa bệnh nhân với bác sĩ, bất chấp cảnh báo của OpenAI rằng công cụ này không nên được sử dụng trong "các lĩnh vực có rủi ro cao".

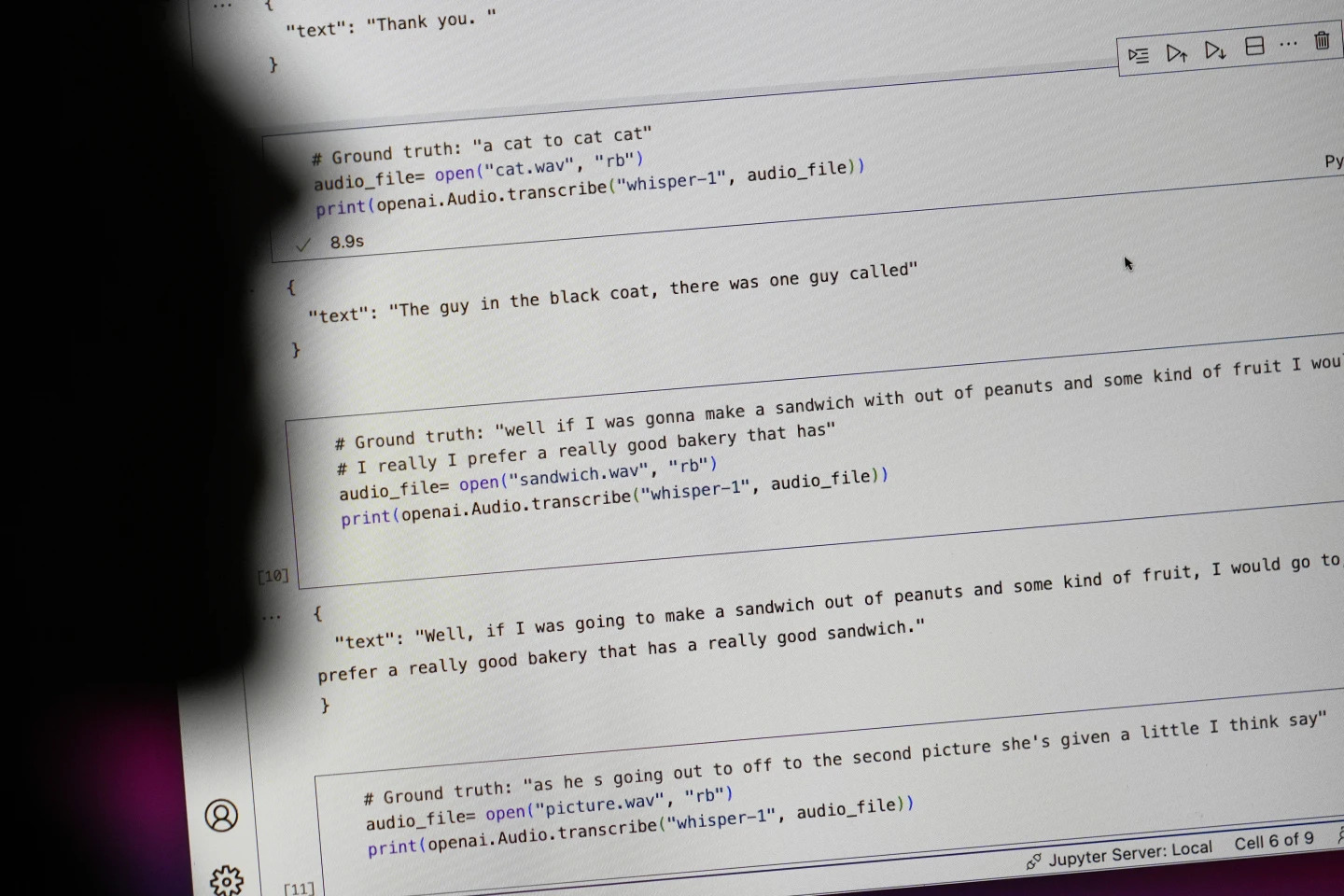

Các câu bắt đầu bằng "#Ground truth" là những gì thực sự được nói, các câu bắt đầu bằng "#text" là những gì Whisper phiên âm. Ảnh: AP

Các nhà nghiên cứu và kỹ sư cho biết Whisper thường xuyên tạo ra ảo giác trong quá trình sử dụng. Ví dụ, một nhà nghiên cứu của Đại học Michigan cho biết ông đã tìm thấy ảo giác trong 8/10 bản ghi âm mà ông kiểm tra.

Một kỹ sư học máy ban đầu phát hiện sự xuyên tạc ở khoảng một nửa trong số hơn 100 giờ bản ghi chép Whisper mà ông phân tích. Một nhà phát triển thứ ba cho biết ông phát hiện ra ảo giác ở gần như mọi bản ghi chép trong số 26.000 bản ghi chép được tạo bằng Whisper.

Ảo giác còn tồn tại ngay cả trong các mẫu âm thanh ngắn được ghi âm tốt. Một nghiên cứu gần đây của các nhà khoa học máy tính đã phát hiện ra 187 sự xuyên tạc trong hơn 13.000 đoạn âm thanh rõ ràng mà họ kiểm tra.

Các nhà nghiên cứu cho biết xu hướng đó sẽ dẫn đến hàng chục nghìn bản ghi lỗi trên hàng triệu bản ghi âm.

Bà Alondra Nelson, giáo sư tại Trường Khoa học Xã hội tại Viện Nghiên cứu Cao cấp, cho biết những sai lầm như vậy có thể gây ra "hậu quả thực sự nghiêm trọng", đặc biệt là trong môi trường bệnh viện.

"Không ai muốn bị chẩn đoán sai. Cần phải có một rào cản cao hơn", bà Nelson nói.

Giáo sư Allison Koenecke của Đại học Cornell và Mona Sloane của Đại học Virginia đã kiểm tra hàng nghìn đoạn trích ngắn mà họ lấy được từ TalkBank, một kho lưu trữ nghiên cứu được lưu trữ tại Đại học Carnegie Mellon. Họ xác định rằng gần 40% ảo giác là có hại hoặc đáng lo ngại vì người nói có thể bị hiểu sai hoặc trình bày sai.

Một diễn giả trong một bản ghi âm đã mô tả "hai cô gái khác và một phụ nữ", nhưng Whisper đã bịa ra thêm bình luận về chủng tộc, thêm vào "hai cô gái khác và một phụ nữ, ừm, là người da đen".

Trong bản phiên âm khác, Whisper đã phát minh ra một loại thuốc không tồn tại có tên là "kháng sinh tăng hoạt tính".

Dù hầu hết các nhà phát triển cho rằng các công cụ phiên âm có thể viết sai chính tả hoặc mắc các lỗi khác, song các kỹ sư và nhà nghiên cứu cho biết họ chưa bao giờ thấy một công cụ phiên âm hỗ trợ AI nào lại gây ảo giác nhiều như Whisper.

Công cụ này được tích hợp vào một số phiên bản chatbot hàng đầu của OpenAI là ChatGPT và là dịch vụ tích hợp trong nền tảng điện toán đám mây của Oracle, Microsoft, phục vụ hàng nghìn công ty trên toàn thế giới. Nó cũng được sử dụng để phiên âm và dịch văn bản sang nhiều ngôn ngữ.

Ngọc Ánh (theo AP)

Nguồn: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Ảnh] Thủ tướng Phạm Minh Chính cùng Thủ tướng Ethiopia tham quan chùa Trấn Quốc](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/18ba6e1e73f94a618f5b5e9c1bd364a8)

![[Ảnh] Tổng Bí thư Tô Lâm tiếp Đại sứ Pháp tại Việt Nam Olivier Brochet](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/49224f0f12e84b66a73b17eb251f7278)

![[Ảnh] Lễ đón Bộ trưởng Quốc phòng Trung Quốc và đoàn đại biểu sang giao lưu hữu nghị](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/fadd533046594e5cacbb28de4c4d5655)

![[Ảnh] Chủ tịch nước Lương Cường tiếp Bộ trưởng Quốc phòng Kenya Soipan Tuya](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/0e7a5185e8144d73af91e67e03567f41)

![[Ảnh] Đầm ấm cuộc gặp giữa hai Phu nhân Thủ tướng Việt Nam và Ethiopia với học sinh khiếm thị Trường Nguyễn Đình Chiểu](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/b1a43ba73eb94fea89034e458154f7ae)

![[Ảnh] Thúc đẩy tình hữu nghị, đoàn kết và hợp tác giữa quân đội và nhân dân hai nước](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/0c4d087864f14092aed77252590b6bae)

![[Video] Viettel chính thức đưa tuyến cáp quang biển lớn nhất Việt Nam đi vào hoạt động](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/17/f19008c6010c4a538cc422cb791ca0a1)

Bình luận (0)