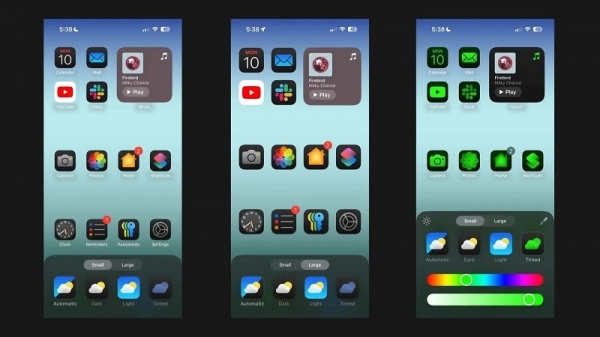

Theo Android Authority, tài liệu nghiên cứu của Apple trình bày chi tiết về giải pháp chạy các mô hình ngôn ngữ lớn (LLM) trên các thiết bị có RAM hạn chế. Bài báo tiết lộ cách công ty có thể lưu trữ "các thông số mô hình" và đưa một phần của chúng vào RAM của thiết bị khi cần thiết thay vì tải toàn bộ mô hình vào RAM.

Apple tìm cách giúp những chiếc iPhone cũ có ít RAM có thể chạy AI tổng quát

Bài báo cho rằng phương pháp này cho phép chạy các mô hình yêu cầu bộ nhớ RAM gấp đôi mà iPhone có thể có nhưng vẫn đảm bảo tốc độ suy luận tăng gấp 4 - 5 lần và 20 - 25 lần so với các phương pháp tải đơn giản vào CPU và GPU tương ứng.

Việc triển khai AI tổng hợp trên thiết bị có nhiều RAM sẽ mang lại lợi ích lớn vì nó cung cấp tốc độ đọc/ghi nhanh hơn. Tốc độ nhanh là điều quan trọng đối với AI trên thiết bị, cho phép thời gian suy luận nhanh hơn nhiều vì người dùng không nhất thiết phải đợi hàng chục giây (hoặc hơn) để nhận được phản hồi hoặc kết quả cuối cùng. Tất cả điều này có nghĩa một trợ lý AI trên thiết bị có khả năng chạy ở tốc độ đàm thoại, tạo hình ảnh/văn bản nhanh hơn nhiều, tóm tắt bài viết nhanh hơn… Nhưng giải pháp của Apple có nghĩa là người dùng không nhất thiết cần nhiều RAM để tăng tốc khả năng phản hồi nhiệm vụ AI trên thiết bị.

Cách tiếp cận của Apple có thể cho phép iPhone cũ và mới cung cấp các tính năng AI tổng hợp ngay trên thiết bị của mình. Đó là điều quan trọng vì iPhone của Apple thường cung cấp ít RAM hơn so với các điện thoại Android cao cấp. Ví dụ, dòng iPhone 11 chỉ cung cấp 4 GB bộ nhớ RAM, trong khi ngay cả iPhone 15 thông thường cũng chỉ có 6 GB bộ nhớ RAM.

Apple không phải là hãng di động duy nhất nỗ lực thu nhỏ LLM. Các chip hàng đầu gần đây của Qualcomm và MediaTek đều hỗ trợ độ chính xác INT4 để thu nhỏ các mô hình này. Dù bằng cách nào, các công ty đều đang cố gắng tìm những giải pháp mới để giảm thiểu yêu cầu hệ thống đối với AI trên thiết bị, cho phép ngay cả điện thoại cấp thấp cũng có thể cung cấp tính năng này.

Source link

![[Ảnh] Thủ tướng Phạm Minh Chính chủ trì cuộc họp bàn giải pháp về thuế đối với hàng hóa xuất, nhập khẩu của Việt Nam](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/19b9ed81ca2940b79fb8a0b9ccef539a)

![[Ảnh] Mùa dâu tằm Phúc Thọ – Trái ngọt từ nông nghiệp xanh](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/1710a51d63c84a5a92de1b9b4caaf3e5)

![[Ảnh] Độc đáo các trò chơi dân gian tại Lễ hội làng Chuông](https://vstatic.vietnam.vn/vietnam/resource/IMAGE/2025/4/10/cff805a06fdd443b9474c017f98075a4)

Bình luận (0)