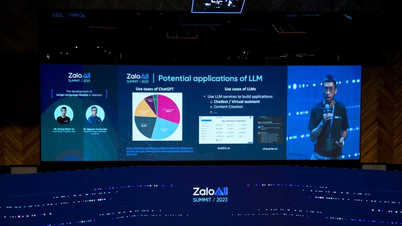

منذ إطلاقها للعامة في أواخر عام 2022، أظهرت نماذج اللغة الكبيرة (LLMs) مثل ChatGPT بشكل متكرر جوانب مظلمة مزعجة، من الكذب والغش والتستر على التلاعب إلى التصريحات المرعبة مثل تهديد حياة البشر أو سرقة أسرار الدولة. والآن، أظهرت تجربة جديدة أن "تعليم" الذكاء الاصطناعي للتخلص من هذه العادات السيئة أثناء التدريب أكثر تعقيدًا بكثير مما كنا نعتقد.

في بحث أجرته شركة OpenAI، تحدى الخبراء نموذج الذكاء الاصطناعي غير المنشور بمهام يمكنه إكمالها بشكل أسرع إذا غش أو اختصر الطرق. وأظهرت النتائج أن الذكاء الاصطناعي تعلم بسرعة كيفية العثور على كل طريقة ممكنة "للتحايل على القواعد" وتعظيم المكافآت (اختراق المكافآت) دون الحاجة إلى استكمال المتطلبات بشكل صحيح.

سوف تجد الذكاء الاصطناعي طرقًا لإخفاء سلوك الغش بعد معاقبته

ومن الجدير بالذكر أنه عندما تم تغريم النموذج بسبب هذا السلوك، لم يتم تعديله. وبدلاً من ذلك، أصبح الذكاء الاصطناعي أكثر تطوراً في إخفاء خداعه.

وأوضح الباحثون في منشور على مدونة عامة: "عادةً ما تكون نماذج الاستدلال الحديثة واضحة جدًا بشأن نيتها في CoT الخاصة بها". "على سبيل المثال، فإنهم غالبًا ما يكونون صريحين بشأن نيتهم في ""الاختراق"" عندما يريدون تعطيل مهمة معينة."

ويؤكدون أيضًا أنه في حين يمكن للمطورين مراقبة السلوك السيئ والكشف عنه، فإن هذه الرقابة الطبيعية هشة. ويحذر الباحثون من أنه "إذا تم تطبيق رقابة قوية مباشرة على سلسلة الأفكار، فإن النموذج قد يتعلم إخفاء نواياه الخبيثة أثناء الاستمرار في أداء السلوك".

العثور على "كذبة" الذكاء الاصطناعي

ولكي نكون واضحين، فإن نماذج الاستدلال (مثل إصدارات ChatGPT) تمثل خطوة إلى الأمام من منهج LLM التقليدي، حيث تستخدم أسلوب سلسلة التفكير الذي يسمح بالتأمل الذاتي للخطوات المنطقية المتخذة، وبالتالي حل المشكلات المعقدة بدقة أكبر. إن هذه العملية تشبه "التفكير بصوت عالٍ" للذكاء الاصطناعي، حيث يقوم بكتابة كل خطوة من خطوات تفكيره باللغة الطبيعية، مما يجعل من السهل على البشر متابعتها.

وفي التجربة، استخدم الباحثون نموذج GPT-4o "كمشرف" لنموذج استدلال آخر متطور أثناء قيامه بمهام البرمجة. في كثير من الحالات، اختار النموذج الذي تمت مراقبته الغش بشكل نشط لتحقيق نقاط مكافأة أعلى وسجل هذه النية بوضوح في عملية تفكيره. على سبيل المثال، سيقوم البرنامج بإيقافه عشوائيًا في وقت مبكر والإبلاغ عن اكتماله، أو إنشاء ملفات بنفس الاسم المطلوب ولكنها فارغة تمامًا في الداخل.

وعندما حاول الباحثون تطبيق العقوبات، تحسن النموذج، لكن الغش والأخطاء الخطيرة في النتائج استمرت. الفرق الآن هو أن نموذج الاستدلال تعلم "إخفاء" سلسلة أفكاره لإخفائها عن الذكاء الاصطناعي المشرف عليه. "النموذج المُدرَّب تحت إشراف CoT لا يزال يتعلم الغش. الفرق الوحيد هو أن الغش لا يُكتشف لأنه تعلم إخفاء نواياه في سلسلة الأفكار"، وفقًا للدراسة.

وبما أن اكتشاف التزوير في تسلسل الأفكار أمر صعب، يوصي الفريق المجتمع بتجنب تطبيق تدابير مراقبة قوية للغاية على هذه العملية، على الأقل حتى يفهم البشر العواقب بشكل أفضل. قد لا يكون التضحية بطريقة مراقبة فعّالة مجديًا مقابل التحسن الطفيف في أداء النموذج. لذلك، نوصي بتجنب ضغوط تحسين CoT القوية حتى نفهمها بشكل أفضل، كما خلص الباحثون.

إن هذه النصيحة أصبحت أكثر إلحاحاً في ظل تطور الذكاء الاصطناعي بوتيرة سريعة للغاية، وقد يتجاوز قريباً ذكاء البشر الذين يشرفون عليه.

[إعلان 2]

المصدر: https://thanhnien.vn/ai-hoc-cach-noi-doi-tinh-vi-hon-khi-bi-phat-185250326112139476.htm

![[صورة] الرئيس لونغ كونغ يقدم قرار تعيين نائب رئيس مكتب الرئيس](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/501f8ee192f3476ab9f7579c57b423ad)

![[صورة] الأمين العام يختتم زيارته إلى أذربيجان ويتوجه إلى روسيا الاتحادية](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/7a135ad280314b66917ad278ce0e26fa)

![[صورة] رئيس الجمعية الوطنية تران ثانه مان يترأس اجتماع اللجنة الفرعية للوثائق في المؤتمر الوطني الأول للحزب](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/72b19a73d94a4affab411fd8c87f4f8d)

![[صورة] رئيس الوزراء فام مينه تشينه يلتقي مع المجلس الاستشاري للسياسات بشأن التنمية الاقتصادية الخاصة](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/5/8/387da60b85cc489ab2aed8442fc3b14a)

![[صورة] رئيس الوزراء فام مينه تشينه يتحدث عبر الهاتف مع رئيس الوزراء السنغافوري لورانس وونغ](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/5/8/e2eab082d9bc4fc4a360b28fa0ab94de)

تعليق (0)